【摘要】探讨GUI Agent在移动端的两种迥异路径。豆包以激进的界面模拟挑战现有安全边界,谷歌则坚守API协作的审慎原则。这背后是技术创新与系统性风险的深刻博弈。

引言

AI Agent正从云端走向终端,手机成为其最重要的载体。新一代AI手机助手不再满足于简单的问答,而是追求直接替用户完成跨应用、多步骤的复杂任务。实现这一目标,目前浮现出两条泾渭分明的主流路径。一条是以豆包手机助手为代表的GUI Agent路线,它像一个“数字人手”,通过模拟点击、输入来直接操控任意App的图形界面。另一条则是以谷歌为代表的API协作路线,它像一个“外交官”,通过与App预设的接口进行标准化通信来完成任务。

豆包的方案,因其通用性和看似强大的能力,一经推出便引发热议。它让用户看到了AI助手的终极形态雏形。但很快,这种“猛踩油门”的激进姿态,撞上了由整个互联网行业历经数十年建立起来的安全与信任“围墙”。与此同时,手握安卓系统和顶尖AI技术的谷歌,在自家产品上却显得异常“克制”,宁愿功能“落后”,也不越雷池一步。

这种鲜明的反差并非偶然。它不是简单的技术优劣或产品进度之争,而是一场关于技术伦理、安全责任、生态协作模式的深度碰撞。本文将从技术原理、安全架构、责任归属和行业生态等多个维度,深入剖析这两种模式的本质区别,并探讨AI Agent在移动端更具可持续性的发展路径。

一、🎯 技术分野:GUI Agent与API协作的根本差异

%20拷贝-bkag.jpg)

要理解豆包与谷歌的选择,首先必须厘清两种技术路径的底层逻辑。它们代表了两种截然不同的系统交互哲学。

1.1 GUI Agent:万能的“数字义手”

GUI Agent,全称图形用户界面智能体(Graphical User Interface Agent),其核心工作原理可以拆解为三个步骤。

感知与理解 (Perception & Understanding):利用多模态大模型,特别是视觉语言模型(VLM),像人眼一样“看懂”手机屏幕上的内容。它能识别出按钮、输入框、文本、图片等UI元素,并理解它们的语义和功能。

推理与规划 (Reasoning & Planning):基于用户的指令(如“帮我打车去机场”),大语言模型(LLM)作为“大脑”,会将这个复杂任务拆解成一系列原子操作步骤。例如,

打开打车App->在目的地输入框输入‘机场’->点击搜索->选择车型->点击确认呼叫。执行与交互 (Execution & Interaction):通过操作系统提供的辅助功能(Accessibility Services)或其他系统级接口,将规划好的操作步骤转化为真实的屏幕点击、滑动和文本输入事件,从而模拟人类用户的物理操作。

豆包手机助手的方案正是这一路线的典型实践。它通过与手机厂商深度合作,获取了较高的系统权限,使其“数字义手”能够跨越App的边界,在系统层面执行自动化任务流。这种方式的最大优势在于其通用性。理论上,只要是人能通过触摸屏操作的App,GUI Agent就能学习和模仿,无需App开发者进行任何专门的适配。

1.2 API协作:严谨的“官方信使”

API(Application Programming Interface)协作模式则是一条更为传统和成熟的路径。它不直接与App的图形界面打交道,而是通过App开发者预先定义和开放的“后门”进行通信。

其工作流程如下。

意图识别 (Intent Recognition):AI助手解析用户指令,识别出用户的核心意图和关键参数。例如,从“帮我用支付宝给张三转100块钱”中,识别出

意图:转账、App:支付宝、收款人:张三、金额:100。API调用 (API Calling):AI助手查找支付宝预先注册在系统中的API。该API明确定义了执行转账操作需要哪些参数,以及调用方需要具备何种授权。

授权与验证 (Authorization & Authentication):遵循OAuth 2.0等标准协议,系统会唤起一个授权页面,要求用户亲自登录支付宝账户并明确同意授权AI助手“执行转账操作”。这个过程由支付宝的安全体系全程掌控。

执行与反馈 (Execution & Feedback):授权通过后,AI助手将参数通过API发送给支付宝的服务器。支付宝在自己的安全风控体系下完成交易,并将结果(成功、失败、原因)通过API返回给AI助手,再由助手呈现给用户。

谷歌的Google Assistant和Gemini,以及国内多数主流手机厂商的AI助手,都主要遵循这一模式。它的核心优势在于安全、可控、责任清晰。每一次操作都有明确的授权边界和可追溯的记录。

1.3 两种路径的核心对比

为了更直观地理解二者的区别,我们可以用一个表格来总结。

这两种路径的选择,直接决定了产品后续将面临的安全挑战和生态博弈。

二、🛡️ 豆包的“激进”:对现有安全体系的冲击

豆包方案的“激进”之处,并非技术本身的新奇,而在于它选择了一条直接挑战并试图绕过现有互联网账户安全体系的道路。这个体系是过去二十年,无数公司投入巨量资源,在与黑产的持续对抗中,层层加固建立起来的。

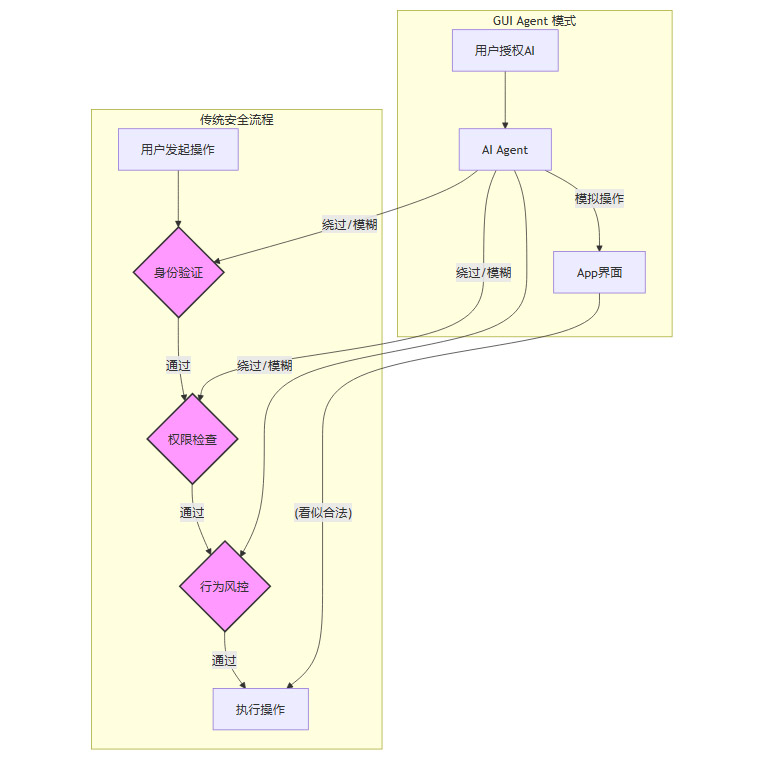

2.1 瓦解三道核心安全防线

现代App,尤其是金融和社交应用,其账户安全体系通常由三道防线构成。豆包的GUI Agent模式,对这三道防线都构成了直接冲击。

2.1.1 第一道防线:身份验证 (Authentication)

传统机制:包括密码、短信验证码、生物识别(指纹/面部)等多因子认证(MFA)。其核心假设是,执行这些验证动作的是用户本人,在一个可信的物理设备上。

GUI Agent的冲击:GUI Agent在获得用户一次性的系统级授权后,其后续操作对于App来说,看起来都像是来自一个已经通过验证的、合法的会话(Session)。它可能在用户不知情的情况下,在后台自动输入密码、处理滑块验证码,甚至调用系统接口“欺骗”需要生物识别的环节。这使得身份验证的有效性被大幅削弱,从“确认是用户本人意愿”降级为“确认是一个获得授权的程序在操作”。

2.1.2 第二道防线:权限控制 (Authorization)

传统机制:App内部有精細的權限管理。例如,一個應用的“讀取聯繫人”權限和“發起支付”權限是分開的。用戶對敏感操作的授權通常是單次、即時的。

GUI Agent的衝擊:GUI Agent獲得的是一個“超級權限”——模擬用戶的任意操作。它模糊了不同操作的權限邊界。用戶授權它“點外賣”,但這個權限在技術上並未被有效限制,它同樣可以去操作用戶的社交軟件或銀行App。這就違背了最小權限原則 (Principle of Least Privilege),帶來了巨大的潛在風險。

2.1.3 第三道防线:行为风控 (Risk Control)

传统机制:后台风控系统会持续分析用户行为模式,如操作速度、点击位置、设备环境、交易习惯等,来识别异常行为(如机器刷单、账户被盗)。

GUI Agent的冲击:AI的操作模式与人类有本质区别。其行为特征可能高度一致、速度极快,容易被风控系统误判为机器人攻击,导致账户被冻结。反之,如果攻击者利用AI Agent发起攻击,其行为又可能被精心设计得与正常用户无异,从而绕过基于人类行为特征建模的风控系统。这使得“人”与“AI”的操作在风控层面难以区分,整个系统的信噪比急剧下降。

我们可以用一个流程图来展示这种冲击。

上图清晰地显示,GUI Agent通过一次性的顶层授权,实质上架空了App内部环环相扣的安全验证逻辑。

2.2 责任归属的“黑洞”

这种模式带来的另一个致命问题是责任归属的混乱。设想一个场景:用户授权豆包助手“在我股票账户A的股价低于10元时,自动卖出1000股”。但由于AI对UI的理解出现偏差,错误地在股价9.9元时,卖出了用户另一个账户B里持有的重要股票,造成了巨大损失。

此时,责任该由谁承担?

用户? 他确实授权了AI进行操作,但并未授权其错误操作。

豆包? 它的AI模型出现了识别错误,但它会辩称这是在用户授权范围内,且技术总有失误率。

股票App? 它的系统忠实执行了来自可信设备会话的指令,完全无法判断操作源于AI的误判。

这种权责不清的状况,在金融支付、银行转账等直接关系到用户财产安全的领域,是绝对无法被接受的。这也是为什么在豆包上线后,多家金融类App迅速采取措施进行限制或屏蔽的核心原因。它们无法承担由第三方AI平台操作失误带来的风险和客诉。

三、🧘 谷歌的“克制”:安全边界内的审慎创新

%20拷贝-cazb.jpg)

与豆包的“横冲直撞”形成鲜明对比,谷歌在AI助手与第三方App的集成上,表现出一种近乎“洁癖”的审慎和克制。这种克制并非技术能力的欠缺,而是基于其长期运营全球性平台和支付体系的经验,对风险和责任的深刻理解。

3.1 API优先,协议为王

谷歌始终将API作为AI助手与外部世界交互的首选,甚至是唯一途径。这意味着,任何功能的实现,都必须建立在与App开发者达成“契约”的基础上。

标准化的授权框架:谷歌强制所有集成遵循OAuth 2.0协议。当Gemini需要访问用户的Gmail或Google Photos时,会弹出一个标准的授权请求页面。页面上会清晰列出AI请求的权限范围 (Scope),例如“读取你的邮件”或“上传照片到你的相册”。用户必须亲自确认。这种机制确保了授权的透明性、最小化和可撤销性。

意图驱动的交互:安卓系统内置了强大的**意图 (Intent)**机制。一个App可以声明它能处理哪些意图,比如“分享图片”或“导航到某地”。AI助手会通过广播意图来调用相应App的功能,而不是去模拟点击。这是一种松耦合、高内聚的架构,保证了各App的独立性和安全性。

3.2 在敏感场景的刻意“留白”

即便在技术上完全可行,谷歌也刻意在涉及用户隐私和资金的敏感操作上设置了“断点”,将最终的决定权交还给用户。

邮件处理:用户可以命令Gemini“帮我找一下上周五市场部发来的那封报告,并根据报告内容起草一封回复邮件”。Gemini会完成信息检索和内容草拟,但绝不会自动点击“发送”。最终的发送动作,必须由用户亲自确认。

支付场景:Google Assistant可以帮你查询账单、设置提醒,但在执行支付时,它会跳转到Google Pay或银行App的支付页面,要求用户通过生物识别或密码进行最终确认。它扮演的是一个高效的“秘书”,而不是一个拥有无限权力的“代理人”。

这种设计哲学,本质上是在用户体验的极致流畅和潜在的巨大风险之间,坚定地选择了后者。谷歌深知,一次资金损失或隐私泄露事件对用户信任的打击,是再多便捷功能也无法弥补的。

3.3 安全与隐私的架构性保障

谷歌的克制还体现在其系统架构层面。

端侧计算 (On-Device AI):通过Private Compute Core等技术,谷歌正努力将更多涉及个人数据的AI计算任务留在手机本地处理。这意味着用户的聊天记录、邮件内容等敏感信息,无需上传到云端服务器,就能被AI模型理解和处理,从物理上隔绝了云端数据泄露的风险。

权限的精细化管理:安卓系统对权限的管控日益严格。从单次授权、使用时授权,到隐私仪表盘,用户对App能访问哪些数据、在何时访问,拥有越来越强的控制力。AI助手作为系统的一部分,同样受到这套体系的严格约束。

总而言之,谷歌的策略可以概括为**“在围栏内跳舞”**。它首先与生态伙伴共同建立一个坚固、透明、规则清晰的“围栏”(即API和安全协议),然后再在围栏内探索AI创新的可能性。

四、⚖️ 隐形成本:技术方案背后的安全与责任博弈

豆包与谷歌的路线之争,表面看是产品理念的差异,深层则是对技术方案“隐形成本”的不同考量。这个成本,就是安全、责任与合规。

4.1 安全模型的根本冲突

GUI Agent模式与现有互联网安全模型存在根本性的冲突。它试图用一个“万能钥匙”去打开所有房间的门,而现代安全设计的核心思想却是“为每扇门配一把专门的钥匙,并且钥匙由房间主人保管”。

这种冲突意味着,如果要让GUI Agent安全地大规模应用,几乎需要重构整个互联网应用的安全基础设施,这是一个极其庞大且复杂的工程。

4.2 责任归属难题的现实类比:自动驾驶

AI Agent替用户操作手机,与自动驾驶汽车替司机开车,在责任划分上高度相似。

L2/L3级辅助驾驶:类似于API协作模式。系统提供辅助,如车道保持、自动跟车,但驾驶员必须时刻保持监控,并对所有驾驶行为负最终责任。这对应AI助手帮你填好表单,但由你亲自点击提交。责任边界相对清晰。

L4/L5级完全自动驾驶:类似于GUI Agent模式。系统在特定场景下完全接管驾驶,理论上驾驶员可以不参与。一旦发生事故,责任主体就变得复杂,可能是汽车制造商、软件供应商,甚至是道路基础设施。这对应AI助手全自动完成一笔复杂的金融交易。

目前,全球各国对于L4/L5级自动驾驶的法律法规、保险理赔体系都还在艰难的探索中,远未成熟。同样,在没有清晰的法律和监管框架之前,在高风险的金融、通信场景中强行推广“L5级”的AI手机助手,是对用户和整个行业不负责任的冒险。

五、🔄 豆包“降档”:从技术冲锋到规则协商

%20拷贝-xsau.jpg)

市场的强烈反应,让豆包的激进探索迅速遭遇现实的阻力。在上线后不久,面对多家主流App的“拒绝服务”和舆论的广泛质疑,豆包发布了官方声明,宣布进行重大调整。

5.1 声明背后的策略转向

豆包的声明核心内容有两点。

主动收缩边界:暂时下线对银行、互联网支付等金融类App的自动操作能力。

寻求对话合作:表示将积极与相关厂商沟通,希望共同制定清晰、安全的AI操作行为准则。

这一调整,标志着豆包的策略从单方面的“技术突围”,转向寻求多方的“规则共建”。这不仅仅是一次简单的功能下线,更是一次深刻的理念转变。它承认了仅凭“用户授权+技术可行”这两点,并不足以支撑一个复杂技术在真实社会中的落地。还需要考虑行业惯例、安全标准、监管要求和生态伙伴的接受度。

这次“降档”,虽然是外界压力下的被动调整,但对整个AI Agent行业的发展而言,却是一次及时的“纠偏”。它让所有从业者意识到,创新不能脱离现实的土壤,技术理想必须尊重既有的社会与商业规则。

六、🛤️ 可持续路径:从“硬控”到“互联”的演进

豆包的实践证明了单边“硬控”App的道路难以走通。那么,AI Agent在手机端更具可持续性的未来是什么?答案正逐渐清晰,那就是走向一种基于开放标准、多方协作的“标准化互联”。

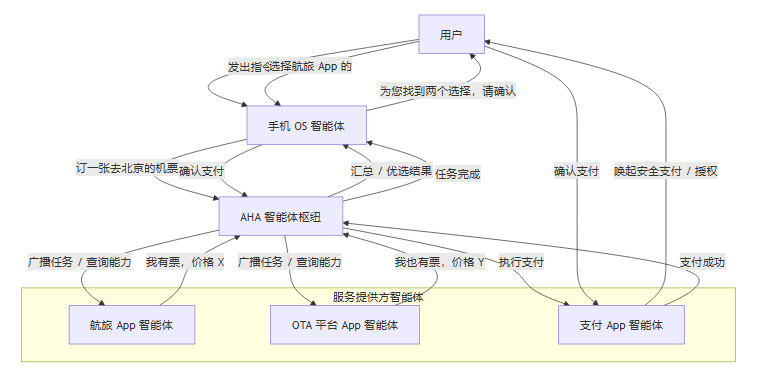

6.1 AHA方案:一种行业协作范式

以OPPO与支付宝联合推出的AHA(Agent Hub Access)智能体互联协同解决方案为例,它为行业提供了一个可行的蓝图。AHA的核心思想不是让一个“超级AI”去控制所有App,而是构建一个中立的“智能体枢纽”,让不同的智能体(包括手机系统助手和App内置的智能体)能够安全、高效地对话和协作。

其工作模式可以简化为以下流程。

6.2 “互联”模式的核心优势

这种基于枢纽的互联模式,相比GUI Agent的“硬控”模式,具备多方面的优势。

安全可控:所有跨智能体的通信都通过标准协议进行,每一次调用都有据可查。敏感操作(如支付)依然由专业的App在其自身的安全闭环内完成,AI助手只负责意图传递和流程协同,不触碰核心安全环节。

责任清晰:在上述流程中,如果机票订错,责任可以清晰地追溯到是航旅App智能体返回了错误信息,还是OS智能体理解错了用户意图。如果发生支付风险,则由支付App的风控体系负责。清晰的边界划分是规模化商业合作的基础。

生态开放:AHA这类方案旨在成为行业标准。它允许不同厂商的手机、不同开发者的App平等地接入这个网络。这避免了由单一巨头通过系统权限垄断AI入口,有利于维持一个健康、多元的创新生态。

能力可组合:每个App只需将自己的核心能力封装成一个“技能”,注册到枢纽中。AI助手可以像搭积木一样,动态组合不同App的技能来完成复杂任务,极大地提升了服务创新的灵活性和效率。

七、🏛️ 顶层设计:国家与行业的标准化之路

%20拷贝-qrsg.jpg)

AI Agent的健康发展,离不开顶层设计的引导。令人欣慰的是,国内的监管和行业机构已经前瞻性地开始了布局。

7.1 标准先行,规范发展

工信部、信通院等机构正在积极推进**《人工智能 智能体互联》系列国家标准**的制定。蚂蚁集团等企业作为核心参编方,将AHA等业界实践经验贡献其中。这些标准重点聚焦于以下几个方面。

互联协议:定义智能体之间如何发现、通信和协作的统一语言。

身份认证:确保参与互联的每个智能体身份可信、不被冒充。

数据安全:规范跨智能体数据流转的加密、脱敏和隐私保护要求。

能力描述:建立一套标准化的方式来描述智能体能做什么、需要什么权限。

7.2 “先立规矩,后办事”的意义

这种“标准先行”的策略,其意义深远。它为整个行业设定了清晰的“交通规则”,避免了因野蛮生长而导致的市场混乱和系统性风险。

降低创新门槛:有了统一标准,中小开发者也能更容易地让自己的App融入AI生态,不必为适配不同手机厂商的私有协议而耗费精力。

保障用户权益:国家标准将安全和隐私保护作为底线,确保了无论用户使用哪个品牌的手机或AI助手,其基本权益都能得到保障。

促进产业协同:标准化的建立,本身就是一个凝聚行业共识的过程。它推动手机厂商、AI公司、应用开发者从博弈走向合作,共同做大蛋糕。

结论

豆包的“猛踩油门”和谷歌的“审慎克制”,共同上演了一场关于AI Agent落地路径的生动案例教学。豆包用一次代价不菲的尝试,验证了单纯的技术理想主义在复杂的现实商业社会中会遭遇怎样的阻力。它提醒我们,任何试图颠覆现有规则的创新,都必须对被颠覆对象的价值——在这里即是互联网安全与信任体系——有充分的敬畏。

谷歌则用其一贯的平台思维,展示了在规则中演进的智慧。它宁愿牺牲一时的功能炫酷,也要坚守安全、合规与生态伙伴关系的底线。这种看似“保守”的策略,实则为技术的长期、可持续发展铺设了最稳固的基石。

GUI Agent作为一项强大的技术,其潜力毋庸置疑。但它的力量必须被关在制度的“笼子”里。未来的AI手机助手,必然是GUI Agent的精准执行能力与API协作的标准化、安全性相结合的产物。它不再是一个孤立的“万能管家”,而是一个庞大、协同的智能网络中的一个可信节点。

真正的先进,从来不只是技术的单点突破,更是技术与规则、创新与责任的和谐共舞。优秀的AI助手,不仅要回答“我能为你做什么”,更要清晰地回答“我如何安全地为你做”以及“如果出错,谁来负责”。

📢💻 【省心锐评】

GUI Agent的狂飙,终将驶入API协作与行业标准的轨道。技术越自由,规则越重要。这不仅是商业模式的选择,更是对用户与社会基础设施的根本责任。

.png)

%20%E6%8B%B7%E8%B4%9D-tnwo.jpg)

评论