【摘要】Gemini的成功并非偶然,其核心驱动力源于谷歌的全栈技术整合、独特的工程师文化回归以及深远的生态布局,用户时长的反超仅是这一系统性优势的表层体现。

引言

人工智能领域的竞争,早已超越了单纯的模型参数与基准测试跑分。当下的战局,更像是一场关于技术栈深度、工程文化效率与生态系统执行力的综合性较量。近期,一个关键指标的变化引起了业界的广泛关注,谷歌Gemini的用户平均停留时长首次超越了ChatGPT。

这个数据本身只是一个结果。其背后,揭示的是一场深刻的战略转型与执行力的回归。从其前身Bard因体验不佳而备受质疑,到如今Gemini在核心用户粘性上实现反超,这并非一次简单的产品迭代,而是一场由技术、文化、战略共同驱动的“逆风翻盘”。本文将从技术架构、工程文化、生态协同及未来布局等多个维度,系统性拆解Gemini此次崛起的底层逻辑。

一、📊 指标的逆转:从“下载量崇拜”到“用户时长为王”

在产品评估的传统视角中,下载量与月活跃用户数(MAU)常被视为黄金标准。但在AI原生应用时代,用户停留时长(Dwell Time)正成为衡量产品真实价值与用户粘性的更精准标尺。

1.1 停留时长,产品价值的试金石

最新数据显示,截至2025年底,Gemini在桌面与移动网页端的用户平均停留时长达到了约7.2分钟。这一数据首次超过了其主要竞争对手ChatGPT的约6分钟,同时也略高于Anthropic Claude。

这个看似微小的变化,信号意义却极为重大。

从“浅尝辄止”到“深度融入”。停留时长的增加,直接说明用户不再将Gemini仅仅作为一个新奇的“玩具”或简单的问答工具。他们愿意投入更多时间,意味着Gemini已经开始深度融入其工作流,无论是代码编写、内容创作,还是复杂问题的研究。

产品体验的质变。更长的停留时间,是模型回答质量、功能设计、响应速度与多模态能力综合提升的直接结果。用户只有在获得持续、可靠、高价值的反馈时,才会愿意在一个产品上花费更多时间。这标志着Gemini成功摆脱了Bard时期“错误频出、体验不稳定”的负面标签。

1.2 下载量的追赶与生态驱动力

尽管在月度下载量上,ChatGPT凭借先发优势仍以约8700万次保持领先,但Gemini的增长曲线极为陡峭。其月度下载量从2025年年中的约1500万次,飙升至年底的约6600万次。

这种爆发式增长的核心动力,源于谷歌无与伦比的生态系统整合能力。

原生入口的流量优势。Gemini被深度嵌入到Android操作系统、Google Workspace(包括Gmail、Docs)、Chrome浏览器等拥有数十亿用户的产品中。用户无需额外下载,即可在日常使用的工具中无缝调用Gemini的能力。这种“随风潜入夜”式的渗透,极大地降低了用户获取成本。

场景驱动的自然转化。在Google搜索中直接生成信息图,在Gmail中一键撰写邮件,在Google Docs中进行头脑风暴。Gemini并非一个孤立的应用,而是作为一种底层能力,赋能于用户已有的工作与生活场景。这种场景驱动的模式,用户转化率远高于传统的应用商店推广。

1.3 从Bard的阴影中走出

回顾Gemini的前身Bard,其早期的市场表现并不理想,甚至被贴上了“ChatGPT失败竞品”的标签。如今的数据逆转,不仅是一次产品的成功,更是谷歌AI战略与执行力的一次自我救赎。它证明了谷歌不仅补齐了在大型语言模型应用层的短板,更在技术与产品节奏上重新找回了主动权。

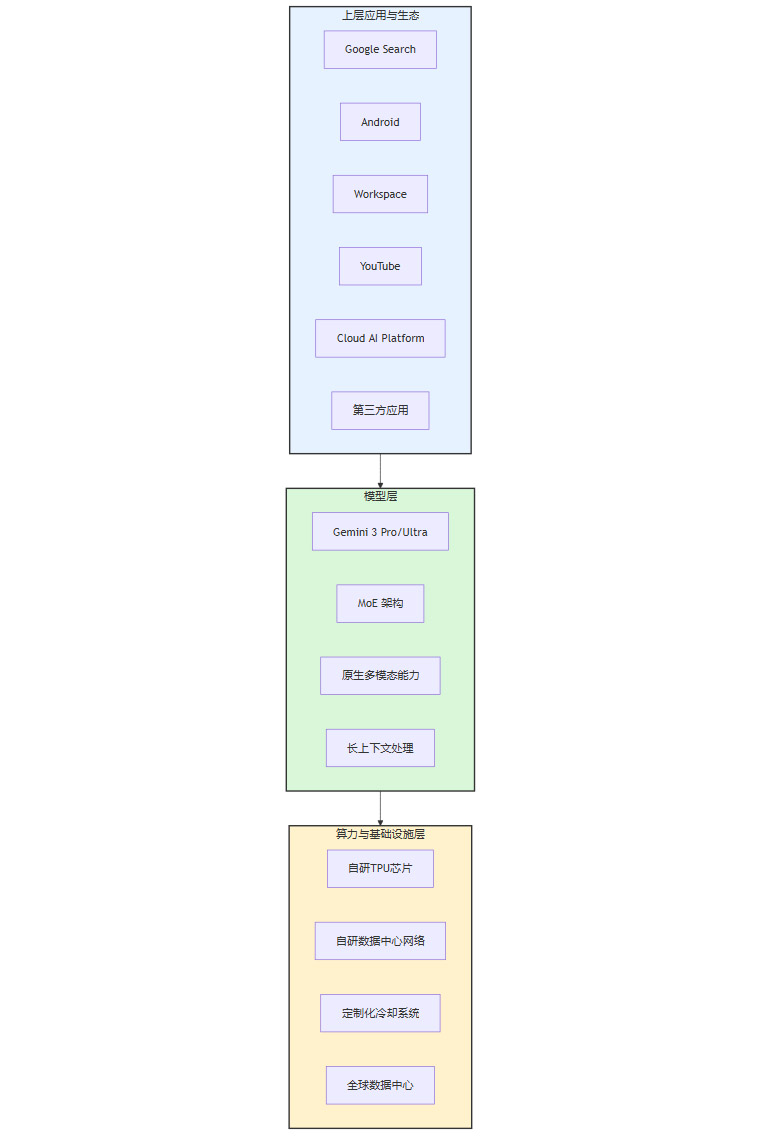

二、🛠️ 全栈技术解构:谷歌的“垂直整合”护城河

Gemini的性能飞跃,根植于谷歌长达十年的“全栈式”技术布局。这种从底层芯片到上层应用,再到基础设施的垂直整合能力,构成了其难以被复制的核心竞争力。

2.1 模型架构的路线分野

在模型架构的选择上,谷歌与OpenAI展现了不同的技术哲学。

2.1.1 Gemini的MoE架构:效率与规模的平衡

Gemini 3采用了稀疏专家混合(Mixture of Experts, MoE)架构。这种架构并非一个庞大的单体模型,而是由多个相对较小的“专家”子模型和一个“门控网络”(Gating Network)组成。

工作原理。当一个请求(Prompt)输入时,门控网络会判断该任务的性质,并动态地选择激活最相关的几个“专家”模型来协同处理。其余大部分专家模型则保持休眠状态。

核心优势。

推理成本可控。由于每次推理只激活一小部分模型参数,其计算成本远低于需要调动所有参数的单体稠密模型。这使得大规模商业化部署的成本效益更高。

训练效率更高。不同专家可以并行训练,更容易扩展到更大的模型规模,同时保持训练效率。

专业化能力。每个专家可以专注于特定领域的知识或任务类型,使得模型在处理多样化、复杂任务时更具优势。

2.1.2 OpenAI的单体模型路径:推理成本的挑战

相比之下,OpenAI的GPT系列模型更倾向于采用单体稠密模型(Dense Model)的路径。这种模型在每次推理时,都需要激活几乎全部的参数。

优势与挑战。稠密模型在通用能力和知识的广度上表现出色,但其训练与推理成本随着模型规模的增长呈指数级上升。这导致其在推理速度、运行效率和API成本上,面临比MoE架构更大的挑战。

这种架构上的差异,直接体现了谷歌工程思维与OpenAI算法思维的不同侧重。谷歌更注重系统效率与大规模部署的可行性,而OpenAI则在算法的极致探索上投入更多。

2.2 原生多模态与长上下文:解锁复杂任务

Gemini 3的一大技术亮点是其原生多模态(Native Multimodality)能力。它并非通过简单的“拼接”来处理不同模态的数据,而是在模型设计之初就统一了对文本、图像、音频、视频等多种信息的处理范式。

跨模态逻辑推理。这使得Gemini能够处理复杂的“长链路任务”。例如,分析一段包含图表、文字和旁白的科研讲座视频,并总结其核心论点。在ARC-AGI-2这类高难度多模态推理数据集上,Gemini 3 Pro取得了23.4%的得分,显著领先于其他竞品。

百万级Token长上下文。Gemini API已支持百万级Token的长上下文输入。这意味着它可以一次性处理整本书、一份完整的财报或一个复杂的代码库。这为企业级的文档分析、知识库问答、软件工程等复杂应用场景打开了大门,是其从“聊天机器人”迈向“生产力平台”的关键一步。

2.3 从TPU到数据中心:十年磨一剑的算力底座

如果说模型架构是软件层面的创新,那么谷歌自研的算力基础设施则是其硬件层面的“杀手锏”。

2.3.1 自研芯片TPU的演进

谷歌从十多年前就开始布局专为机器学习设计的张量处理单元(Tensor Processing Unit, TPU)。TPU针对神经网络中的核心运算——矩阵乘法进行了深度优化,相比通用GPU,在AI训练和推理任务上拥有更高的能效比。Gemini的训练与推理,完全运行在谷歌自家的TPU集群上,形成了软硬件的深度协同。

2.3.2 基础设施一体化:网络与冷却

谷歌的全栈优势不止于芯片。它还自研了数据中心内部的光交换网络、服务器冷却系统等关键基础设施。这种端到端的控制力,使得谷歌可以最大限度地优化AI负载的运行效率,降低延迟,提升吞吐量。

下面是一个简化的谷歌全栈AI技术栈示意图。

这种“芯片-模型-应用”的垂直整合,构成了谷歌坚固的技术护城河。它不仅保证了Gemini的性能,更在成本控制和迭代速度上赋予了谷歌巨大的战略优势。

三、👨💻 工程师文化的回归:创新的“第一性原理”

技术上的领先,离不开组织文化与人才机制的支撑。Gemini的快速崛起,在很大程度上也归功于谷歌内部一场深刻的“文化复兴”。

3.1 “Blue Micro Kitchen”效应:小团队的高密度协作

谷歌CEO Sundar Pichai在多次访谈中提到了一个名为“Blue Micro Kitchen”的工作区。这里聚集了来自原Google Brain和DeepMind的核心模型团队。其工作模式,让他联想到了谷歌创立初期的氛围。

顶尖人才的聚集。在这个空间里,包括谷歌联合创始人Sergey Brin、AI大神Jeff Dean、分布式系统专家Sanjay Ghemawat在内的顶尖工程师与研究员,与一线团队并肩工作。

“下场写代码”。这些技术领袖并非仅仅进行战略指导,而是亲自动手编写代码、调试模型、参与讨论。这种扁平化的协作方式,极大地压缩了决策链条。

高密度物理空间。团队被刻意安排在极小的空间内,频繁的面对面交流取代了冗长的会议和邮件。思想的碰撞与技术的迭代速度被推向极致。

这种“小而密集”的精英团队模式,被认为是Gemini能够在短时间内整合资源、攻克技术难关、加快产品节奏的关键催化剂。它证明了在AI研发的攻坚阶段,顶级人才的组织方式,比单纯的资源堆砌更为重要。

3.2 工程师主导的“登月文化”

Gemini的开发,在内部被视为与AlphaFold(蛋白质结构预测)、Waymo(自动驾驶)、Wing(无人机配送)同等级别的“登月项目”(Moonshot Project)。

这种文化鼓励团队挑战那些看似不可能完成的宏大目标,并给予他们极高的自由度和资源支持。它强调的不是短期的商业回报,而是长期的技术突破。将Gemini置于这一文化框架下,意味着谷歌对其的定位并非一个简单的防御性产品,而是一个着眼于未来十年、引领下一代计算平台的核心战略支点。

3.3 文化如何转化为产品节奏

工程师文化的回归,直接体现在了产品迭代的速度和质量上。

快速决策与迭代。由于技术领袖深入一线,许多技术路线的选择和工程难题的解决,都可以在现场快速拍板,避免了层层汇报带来的时间损耗。

问题驱动的务实作风。工程师主导的文化,更倾向于从解决实际问题出发,而不是停留在理论探讨。这使得Gemini的功能开发更贴近用户真实需求,产品体验的改进也更为迅速。

四、🌐 生态协同与开发者赋能:从封闭矩阵到开放平台

一个AI模型的最终影响力,取决于其生态的广度与深度。谷歌正在将Gemini打造为其庞大产品矩阵的“AI中枢”,并以此为基础,构建一个开放的开发者生态。

4.1 谷歌产品矩阵的“AI中枢”

Gemini并非一个孤立的聊天应用,而是作为一种基础能力,被注入到谷歌几乎所有的核心产品线中。

这种全线产品赋能的策略,不仅为Gemini带来了海量的用户入口和真实世界的数据反馈,也让谷歌的每一个产品都因AI的加持而获得了新的生命力。

4.2 第三方开发者的选择:成本与性能的考量

谷歌正积极推动第三方开发者拥抱Gemini。Copilot、Replit、Figma等知名开发工具和设计平台,已经开始集成Gemini的能力。

开发者选择Gemini API,主要基于以下几点考量。

更低的推理成本。得益于MoE架构和TPU的效率,Gemini API在同等性能下,通常能提供比竞争对手更具吸引力的价格。

更高的并发性能。谷歌强大的基础设施,能够支持极高的API并发请求,满足大型应用的需求。

与谷歌生态的天然集成。对于那些业务本就构建在Google Cloud、Firebase或Android平台上的开发者而言,使用Gemini API可以获得更无缝的集成体验。

4.3 开启“全民开发者”时代

Gemini的普及,正在深刻地改变软件创造的方式,其最终目标是降低技术门槛,激发全民创造力。

代码生成与原型设计。产品经理或市场人员,可以直接通过自然语言描述,让Gemini生成一个带动画效果的HTML页面原型,用于快速验证创意。

个性化应用创建。非工程师背景的用户,可以利用Gemini创建用于教学或个人演示的简单应用,而无需编写一行代码。

这种趋势预示着一个“全民开发者”(Citizen Developer)时代的到来。模型成为了幕后的超级工程师,而人类的创造力则被前所未有地解放出来。正如Sundar Pichai所说,“我们现在看到的工具,是它们‘最差的一版’,未来只会越来越好

五、🚀 面向未来的十年棋局:从太空算力到技术栈纵深

谷歌对AI的布局,并未止步于当前的产品竞争,而是延伸到了更长远的基础设施与技术路线的探索。其“Suncatcher项目”等前瞻性计划,揭示了其对未来十年甚至更长时间的深远思考。

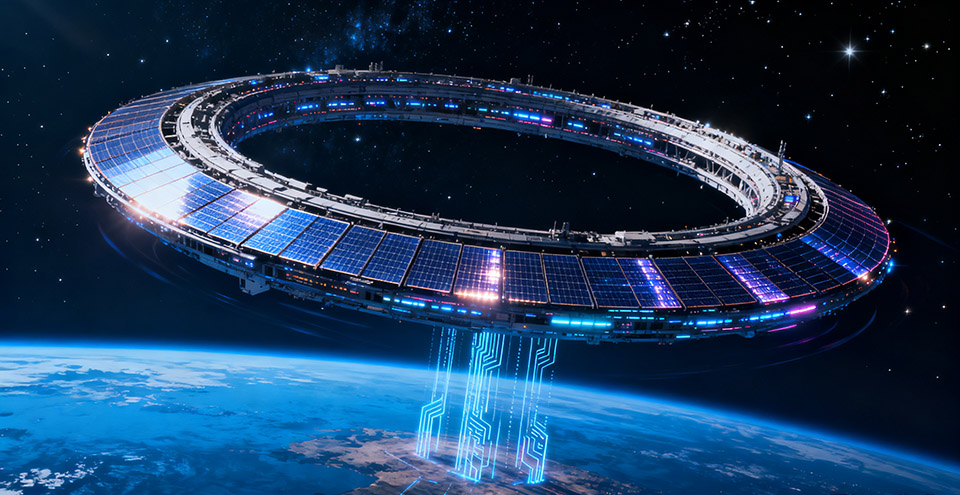

5.1 “Suncatcher项目”:将数据中心送入太空

谷歌正在推进一项名为“Suncatcher”(捕日者)的宏大计划,其核心目标是在太空中建设AI数据中心。

5.1.1 计划的驱动力:能源与散热瓶颈

这个看似疯狂的想法,背后有着坚实的逻辑支撑。

能源瓶颈。AI模型的训练与推理是巨大的能源消耗黑洞。随着模型规模的持续膨胀,地面电网将难以承受未来AI算力的能源需求。而在近地轨道,卫星可以接收到近乎24小时不间断的太阳能,从根本上解决了能源供应问题。

散热挑战。数据中心的另一大运营成本来自冷却系统。太空的低温真空环境,为服务器散热提供了天然的、近乎零成本的解决方案。

5.1.2 实施路线图

“Suncatcher项目”并非空中楼阁,而是有着清晰的实施路径。

原型验证。谷歌计划最早于2027年,与卫星公司Planet Labs合作,发射搭载定制TPU芯片的原型卫星。此举旨在验证在近地轨道部署和运行AI算力的技术可行性。

成本预期。根据谷歌的内部测算,随着发射成本的降低和技术的成熟,到2030年代,天基AI算力的单位成本有望与地面数据中心持平,甚至更低。

“Suncatcher项目”与AlphaFold、Waymo等“登月计划”一脉相承,它体现了谷歌习惯于从第一性原理出发,为行业面临的终极挑战寻找颠覆性解决方案的思维方式。这不仅是对未来算力需求的布局,更是对AI时代能源基础设施的重新定义。

5.2 战略路线的分野:全栈整合 vs. 算法聚焦

通过对Gemini和ChatGPT背后公司的战略进行比较,可以清晰地看到两条截然不同的发展路径。

谷歌的战略优势在于其系统性的闭环能力。全栈布局使其在性能优化、成本控制和迭代速度上拥有更大的自主权。而OpenAI的优势则在于其专注与灵活,能够集中所有资源在模型算法上进行快速突破,并通过与微软等巨头的战略合作迅速实现商业化。

这两条路径并无绝对的优劣之分,但它们揭示了AI巨头对未来竞争格局的不同判断。谷歌押注的是,长远来看,对底层基础设施的掌控力将成为最终的胜负手。

5.3 训练与推理效率的深层优势

全栈布局带来的最直接好处,体现在训练与推理的效率上。

能效比。由于TPU是为AI负载量身定制的,其在执行神经网络运算时的每瓦性能(Performance per Watt)远高于通用GPU。这意味着在完成相同计算量时,谷歌的能耗更低。

端到端优化。谷歌可以从模型算法、编译器(如XLA)、硬件指令集到数据中心网络进行全链路优化,最大限度地消除系统瓶颈,提升整体运行效率。

这种效率优势,在模型规模日益庞大的今天,其重要性愈发凸显。它不仅意味着更低的运营成本,更意味着更快的模型迭代速度和更强的市场响应能力。

结论

Gemini对ChatGPT在用户时长这一关键指标上的超越,并非一次孤立的技术突袭或产品营销的胜利。它是一场系统性战役的阶段性成果,其背后是谷歌长达十年的深厚积累与一场及时的文化变革。

全栈技术是基石。从自研TPU到全球数据中心,从MoE架构到原生多模态,谷歌的垂直整合能力构成了Gemini性能与效率的坚实底座。

工程师文化是引擎。“Blue Micro Kitchen”所代表的小团队、高密度、工程师主导的协作模式,为技术创新注入了强大的加速度。

生态系统是放大器。将Gemini无缝融入搜索、Android、Workspace等数十亿用户的产品中,是其实现快速普及和用户粘性提升的关键。

前瞻布局是远见。“Suncatcher”等计划表明,谷歌的目光已投向未来十年的算力与能源格局,致力于解决AI发展的终极瓶颈。

这场“逆风翻盘”的故事,为所有投身于人工智能领域的企业和个人提供了一个深刻的启示,决定AI时代最终胜负的,或许并非一两个模型的领先,而是在基础架构、创新文化和生态整合这些更底层维度上的长期主义与坚定执行。Gemini的崛起,让业界重新审视了这位科技巨头的技术护城河与未来雄心。

📢💻 【省心锐评】

Gemini的逆袭,本质是工程主义对算法浪漫主义的一次现实主义胜利。当竞争进入深水区,决定胜负的不再是灵光一闪,而是从芯片到应用,再到文化的系统性力量。

.png)

评论