【摘要】AI Agent正从“万能”幻象回归“专才”本质。其落地成功依赖于明确的岗位定义、严格的边界认知、系统的工程实践与持续的运营迭代,而非单纯的技术堆砌。

引言

AI Agent的热潮之下,喧嚣与沉寂并存。一方面,炫酷的Demo层出不穷,描绘着自动化一切的未来;另一方面,高达95%的项目在生产环境中遭遇失败,面临低留存、高成本、价值难证的窘境。这种巨大的落差,源于行业初期对Agent能力的普遍误判。

许多团队试图打造“万能助手”,却最终交付了“低能巨婴”。这种从“大而全”到“一无是处”的滑落,正倒逼我们重新审视Agent的本质。它不是无所不能的魔法,而是一项需要被精确约束和深度工程化的技术。

本文旨在提供一套系统性的产品方法论,探讨AI Agent如何摆脱“万金油”的定位陷阱,通过深度垂直化,蜕变为真正能为行业创造价值的“数字专才”。我们将从价值重构、战略定位、工程实践到运营迭代,逐层拆解其落地路径。

一、 🎯 “万能助手”的失效:从幻象到现实的落差

%20拷贝.jpg)

通用型Agent的失败并非偶然,而是其产品范式内在缺陷的必然结果。当一个产品试图解决所有问题时,它往往无法在任何一个问题上做到足够好。

1.1 典型失败范式剖析

实践中,我们看到了大量相似的失败案例,它们共同指向了“泛而不精”的致命伤。

通用办公助手。这类产品功能列表看似华丽,涵盖邮件撰写、会议纪要、PPT生成等。但用户实际使用时发现,每一个单点功能都弱于市面上成熟的垂直工具。更严重的是,用户需要投入极高的前置成本来提供上下文,而Agent生成的初稿又需要大量人工修正,导致“人机协同”变成了“人伺候机器”,用户在一次尝试后便迅速流失。

全科教育助手。一些产品号称覆盖从小学到大学的全学科辅导。结果是,其数学解题不如专业拍照搜题App精准,英语作文批改不如专业语法工具细致,心理咨询功能更是因缺乏专业资质和深度理解而引发合规风险。它试图成为所有人的老师,最终却不是任何人的好老师。

多功能电商客服。这类Agent试图包揽售前咨询、订单查询、售后处理等所有环节。但在关键任务上,如精准查询实时物流状态,其表现往往不如一个简单的规则机器人。当用户最核心、最急迫的需求无法被满足时,其他附加功能便失去了意义。

1.2 失效的根源性诊断

这些失败案例的背后,是四个共通的根源性问题。

缺少明确的主任务 (Lack of Primary Mission)。产品没有一个清晰、可被用户快速感知的核心价值点。功能堆砌导致用户认知模糊,不知道在什么场景下应该首先想到它。

过高的上下文成本 (High Context Cost)。通用场景意味着Agent对背景知识一无所知。用户每次交互都必须从头开始“喂”数据,这个过程本身就极度消耗精力,抵消了AI带来的效率优势。

不稳定的输出质量 (Unstable Output Quality)。大模型的随机性导致通用Agent的输出质量飘忽不定。在没有针对特定场景进行深度优化的前提下,它时而惊艳,时而“智障”,无法给予用户稳定的预期,也就无法建立信任。

极差的任务复用性 (Poor Reusability)。由于每次任务都需要重新配置上下文,导致任务流程难以固化和复用。用户无法将其沉淀为可靠的工作流,产品也就无法融入用户的日常。

二、 🧩 价值内核重构:为Agent定义“数字员工”岗位

要走出“万能助手”的困境,首先需要进行一次彻底的认知重构。我们不应将Agent视为一个无所不能的技术实体,而应将其看作一个待招聘的“数字员工”。这个比喻的核心在于,先有岗位需求,再有员工能力。

2.1 核心理念转变,从技术工具到业务伙伴

将Agent拟人化为“员工”,能帮助我们从业务视角出发,而非技术视角。一个公司招聘员工,绝不是因为他“什么都会一点”,而是因为某个具体岗位上需要他完成特定职责,创造明确价值。

价值导向。我们关注的不再是Agent“能做什么”,而是“应该做什么”才能解决业务问题。

边界意识。任何员工都有其职责边界和能力上限。我们必须为Agent定义清晰的“三不管”原则,避免越权和失职。

协同关系。Agent不是孤立的,它需要与现有的人类员工和业务系统协同工作,成为组织能力的一部分。

2.2 构建Agent的“岗位说明书”

为Agent产品设计的核心,就是为其撰写一份详尽的“岗位说明书”(Job Description)。这份文档是后续所有产品设计、技术研发和运营评估的基石。它强制我们把模糊的产品想象,转化为具体、可执行的业务需求。

这份说明书应至少包含以下几个模块。

通过这样一份结构化的文档,我们将一个模糊的“AI助手”概念,锚定成了一个权责清晰、价值明确的“数字员工”。

三、 ⚖️ 能力与风险边界:认清大模型的硬约束

%20拷贝.jpg)

在为Agent设计岗位时,必须清醒地认识到其底层技术,即大语言模型(LLM),并非万能。它存在一系列固有的技术约束,这些约束直接决定了Agent产品设计的可行性边界。

3.1 技术硬约束的四个维度

可靠性 (Reliability)。LLM的输出存在随机性,即“漂移”。同样的输入,在不同时间可能产生不同的输出。在需要多步推理和执行的复杂任务中,这个问题会被指数级放大。一个简单的数学事实是,即便单步任务的成功率高达99%,一个包含20个步骤的Agent任务,其整体成功率也只有 (0.99)^20 ≈ 82%。对于金融交易、医疗诊断等高风险场景,这是不可接受的。

准确性 (Accuracy)。LLM会产生“幻觉”,即一本正经地编造事实。通用Agent在没有特定领域知识约束的情况下,幻觉问题尤为严重。例如,客服Agent可能引用不存在的售后条款,合同审查Agent可能援引已废止的法律条文。

成本与时延 (Cost & Latency)。调用大型模型的API成本高昂。对于高并发、高频次的应用场景,API费用可能迅速侵蚀业务利润。同时,大型模型的推理时延通常在秒级,无法满足实时交互或低延迟处理的要求。

合规与信任 (Compliance & Trust)。数据隐私和安全是Agent落地的红线。如何确保用户数据不被用于模型训练、如何进行有效的数据隔离和权限管理,是所有ToB产品必须解决的问题。此外,由于其决策过程不透明,用户天然对其缺乏信任,尤其是在处理关键业务时。

3.2 落地策略,从“人机协同”起步

鉴于上述约束,当前阶段最务实、最可靠的落地策略,是优先采用“智能辅助+人工复核”的人机协同模式,而非盲目追求100%的全自动化。

AI作为“初筛器”和“加速器”。让Agent完成80%的重复性、模式化的工作,例如,从海量文档中提取信息、生成报告初稿、识别明显异常。

人类作为“决策者”和“质检员”。由专业人员对Agent的输出进行最终审核、确认和修正,确保结果的准确性和专业性,并对最终结果负责。

这种模式的优势在于,它既利用了AI的效率,又保留了人类的严谨和智慧,在创造价值的同时有效控制了风险。成功的法律合同审查Agent正是这一模式的典范。

四、 🧭 战略基石:精准定位与场景筛选

明确了Agent的“数字员工”定位和能力边界后,接下来的核心任务是在广阔的可能性中,找到那个最适合“招聘”AI员工的“岗位”。这个过程需要一套系统性的战略定位与场景筛选方法。

4.1 产品定位的灵魂三问

在任何Agent项目启动前,产品负责人必须清晰回答以下三个问题。这三个问题能过滤掉绝大多数不切实际的想法。

为谁服务 (Target Audience)?用户画像必须足够具体。是服务于专业人士(如律师、开发者)还是普通消费者?是ToB还是ToC?不同用户群体的知识背景、容错能力和付费意愿截然不同。例如,一个为开发者设计的API文档查询Agent,可以容忍一定的技术术语;而一个为老年人设计的健康咨询Agent,则必须使用最通俗易懂的语言。

解决什么具体痛点 (Specific Pain Point)?痛点必须是“一根针”,而不是“一张网”。“提升办公效率”是一个模糊的目标,而“将每周一的销售数据周报撰写时间从2小时缩短到10分钟”则是一个具体、可衡量的痛点。痛点越具体,Agent的“岗位职责”就越清晰,产品就越容易成功。

自动化到什么程度 (Degree of Automation)?基于前述的能力边界分析,明确定义Agent在工作流中的角色。是提供100%的自动化执行,还是80%的智能辅助?这个决策直接影响产品的风险控制、用户交互和价值定位。例如,在内容创作领域,可以追求较高程度的自动化;但在财务审批领域,则必须以辅助决策为主。

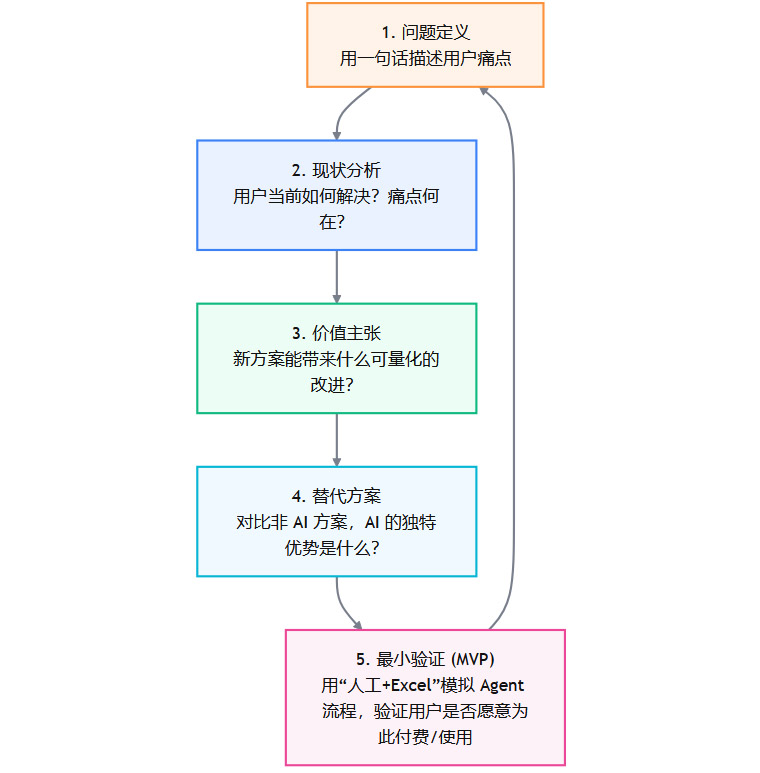

4.2 需求验证的五步闭环

在锁定初步方向后,切忌直接投入研发。必须通过一个低成本的闭环来验证需求的真实性和价值。这个过程可以不依赖任何AI技术。

这个五步法的核心在于第5步,即“Wizard of Oz”测试。在开发任何代码之前,先用人力模拟AI Agent的服务流程。例如,你想做一个智能财报分析Agent,可以先让一个实习生手动分析财报,然后把结果发给种子用户。如果用户愿意为这个“人工服务”付费,并持续使用,才证明了这个需求的真实价值。这个方法能以最低成本,避免团队陷入“技术自嗨”的陷阱。

4.3 高价值场景的“四高”标准

什么样的场景更适合引入AI Agent?经过大量实践,我们总结出了一套“四高”筛选标准。

高价值 (High Value)。场景能直接带来显著的经济效益或业务提升。例如,在金融反欺诈场景中,每成功拦截一笔欺诈交易,就能为银行挽回数万甚至数十万的损失。价值越容易量化,产品就越容易获得预算和支持。

高容错 (High Fault Tolerance)。任务执行过程中,偶尔的错误不会导致灾难性后果。例如,营销文案生成,某个用词不当可以通过人工修改轻易纠正。相反,自动驾驶、医疗手术等场景容错率极低,不适合当前阶段的Agent技术。

高结构化 (High Structure)。任务的流程、输入和输出相对固定和清晰。例如,从发票中提取关键字段,其流程和目标都非常明确。而创意策划、战略咨询等高度开放和模糊的任务,则难以让Agent有效执行。

高壁垒 (High Barrier)。场景需要深厚的行业知识(Domain Knowledge)或专有数据。这构成了产品的护城河。如果一个Agent能被开源模型轻易复现,那么它就没有长期竞争力。法律、医疗、科研等领域是典型的高壁垒场景。

4.4 场景评估的四象限矩阵

结合任务的执行难度和容错率,我们可以构建一个四象限矩阵,来辅助场景选择和制定优先级。

一个稳健的产品路径,通常是从“明星区”切入,快速验证产品价值,积累用户和数据。在站稳脚跟后,再逐步向需要更深行业理解和更复杂技术的“机会区”拓展。

五、 🔩 产品落地关键:从设计到工程的实践闭环

%20拷贝.jpg)

战略定位清晰之后,成功与否便取决于执行的细节。一个优秀的Agent产品,是产品设计、技术工程与用户体验的精密结合体。它需要在自主性与可控性、智能与透明之间找到微妙的平衡。

5.1 设计“可控的自主性”

Agent的核心魅力在于其自主性,但失控的自主性则是灾难。设计的关键在于,赋予Agent足够的自主权以提升效率,同时设立明确的护栏以控制风险。

5.1.1 渐进式授权模型

不要指望一步到位地授予Agent完全的自主权。应该像培养新员工一样,采用渐进式授权。

观察模式 (Observe Mode)。初期,Agent只观察人类操作和业务流程,不执行任何动作。它的任务是学习和提出建议。例如,观察客服人员如何回复工单,然后提示“对于这类问题,您或许可以这样回答”。

辅助模式 (Assist Mode)。在建议的准确率得到验证后,允许Agent执行一些低风险、可逆的操作,但每一步都需要人类点击确认。例如,自动填写表单草稿,等待用户提交。

半自动模式 (Semi-auto Mode)。对于特定类型的、已证明可靠的任务,允许Agent自动执行,但将结果置于待审核队列,由人类批量复核。例如,自动对客服通话进行初次质检打分。

全自动模式 (Full-auto Mode)。仅对极少数风险极低、确定性极高的任务,授予完全的自主执行权限,并建立事后审计机制。

5.1.2 任务分级与“刹车”机制

将Agent能处理的任务按风险和复杂度分级。系统必须内置一个全局的“刹车”机制,一旦监测到异常(如API连续报错、输出内容触发敏感词、任务耗时远超预期),能立即暂停Agent,并将控制权交还给人类。这种人工接管机制是用户信任的最后一道防线。

5.2 构建透明与可解释的交互

用户对AI最大的恐惧,源于其“黑盒”特性。要建立信任,就必须最大限度地提升其决策过程的透明度。

提供决策的证据链。当Agent给出一个结论时,必须附上其推理的依据。例如,数据分析Agent在报告“本季度销售额下降5%”时,应能链接到具体的数据源、计算公式和相关图表。

显式表达不确定性。当Agent对某个判断没有十足把握时,应该主动承认。例如,使用“根据现有信息,我有80%的把握认为…”或“这个问题可能存在多种解释…”这样的措辞,而不是给出斩钉截铁的错误答案。

允许用户调整关键参数。在适当的环节,向用户开放一些关键参数的调整权限,让他们能影响Agent的行为。这不仅能让Agent更好地适应个性化需求,更能极大地增强用户的掌控感和信任感。

5.3 上下文工程与工具编排

如果说LLM是Agent的“大脑”,那么上下文工程 (Context Engineering) 和工具编排 (Tool Orchestration) 就是其连接现实世界的“神经和四肢”。这是将模型“聪明”转化为业务“有用”的关键,也是区分专业团队与业余玩家的分水岭。

5.3.1 上下文工程,让Agent“知情”

上下文是Agent做出正确决策的基础。核心技术是检索增强生成 (RAG),但生产级的RAG远比简单的向量检索复杂。

多层检索策略。结合关键词、向量、图谱等多种检索方式。例如,先用关键词做粗筛,再用向量做精排,最后用知识图谱进行关系推理,确保找到最相关的知识。

会话记忆与状态管理。Agent必须能记住多轮对话的历史,并理解当前任务所处的阶段。这需要精细的状态机设计,确保Agent在长流程任务中不会“失忆”。

知识库的持续更新。业务知识是动态变化的。必须建立一套机制,让业务人员可以方便地更新知识库,并通过自动化流程(如CI/CD)确保Agent能及时学习到最新的信息。

5.3.2 工具编排,让Agent“能干”

Agent的执行能力,来自于它能调用的各种“工具”(API)。

工具调用策略。Agent需要学会判断何时、以及如何调用哪个工具。这通常通过ReAct (Reasoning and Acting) 等思维链框架实现。Agent首先进行推理,生成调用工具的计划,然后执行,并根据工具返回的结果修正下一步计划。

健壮的错误处理。API调用可能会失败(网络问题、权限不足等)。Agent必须具备强大的错误处理和重试机制,而不是一次失败就卡死。

与业务系统的深度集成。真正的护城河,在于Agent能与企业的核心业务系统(如CRM、ERP、OA)深度集成。这意味着需要投入大量的工程资源进行API适配和数据打通。

5.4 成本与SLA工程

在生产环境中,效果、成本、时延是一个永恒的“不可能三角”。优秀的工程实践,是在三者之间找到最佳平衡点。

大小模型协同 (Mixture of Experts)。并非所有任务都需要最强大的模型。可以设计一个路由层,根据任务的复杂度,将其分发给不同能力和成本的模型。简单的意图识别用小模型,复杂的报告生成用大模型。

缓存与批处理。对于重复性的查询,引入缓存机制能大幅降低API调用成本和时延。对于非实时的任务,通过批处理异步执行,可以有效利用计算资源,平摊成本。

规则与算法协作。不要迷信LLM能解决一切。对于确定性强的逻辑,使用传统的规则引擎或算法,往往比LLM更可靠、更高效、成本更低。Agent应该是LLM与传统软件工程的最佳结合。

5.5 安全与合规的底线思维

安全与合规是企业级Agent产品的生命线,必须在产品设计之初就深度嵌入。

数据隔离与权限最小化。严格遵守多租户数据隔离原则。Agent访问内部系统时,必须遵循权限最小化原则,只授予其完成任务所必需的最少权限。

审计与可追溯性。Agent的所有关键操作都必须留下详细的日志,确保事后可审计、可追溯。

PII脱敏与行业合规。在处理用户数据前,自动进行个人身份信息(PII)的识别与脱敏。针对金融、医疗等强监管行业,必须严格遵守HIPAA、GDPR等合规要求。

六、 📈 迭代与演进:从试点到规模化的运营之道

Agent产品不是一蹴而就的,它是一个需要持续运营和迭代的生命体。一套科学的评估体系和演进路径,是其长期成功的保障。

6.1 AgentOps,构建持续进化的飞轮

AgentOps是专门针对AI Agent的DevOps实践。其核心是建立一个从线上监控、评估、到线下优化、回归测试的闭环。

6.1.1 科学的评估体系

评估Agent不能只看用户满意度,需要一套多维度的量化指标。

6.1.2 失败样本的回灌机制

线上收集到的每一个失败案例,都是优化模型的宝贵数据。必须建立一套流程,让业务人员可以方便地标注失败案例,并将其自动回灌到模型的微调(Fine-tuning)数据集中。同时,这些案例也应被加入到回归测试集,确保未来的模型更新不会重蹈覆辙。

6.2 迭代与扩展的路径规划

Agent的推广应遵循“小步快跑、稳扎稳打”的原则。

单点试点 (Pilot)。选择一个业务部门的一个具体场景作为试点,与种子用户共创,打磨产品。这个阶段的目标不是用户量,而是跑通核心价值闭环。

灰度放量 (Canary Release)。在试点成功后,逐步扩大用户范围。通过A/B测试,对比使用Agent和未使用Agent的业务指标差异,用数据证明其价值。

规模化复制 (Scale-up)。当一个场景被完全验证后,将成功的模式(包括产品设计、工程架构、运营方法)抽象出来,复制到其他相似的业务场景中。

这个过程,也是从前述的“明星区”场景,逐步积累数据、技术和用户口碑,然后谨慎地向更复杂的“机会区”场景拓展的过程。

6.3 构筑长期护城河

Agent产品的短期优势可能来自模型或巧妙的Prompt,但长期护城河则建立在更深层次的壁垒之上。

行业数据与标注。高质量、专有的行业数据是微调出卓越领域模型的基础。

专用模板与工作流。将行业最佳实践固化为Agent的模板和工作流,让新用户可以开箱即用。

与业务系统的深度集成。与客户的CRM、ERP等核心系统打通得越深,替换成本就越高。

持续运营与优化能力。强大的AgentOps体系本身就是一种核心竞争力。

6.4 商业化与ROI的量化证明

最终,Agent产品必须在商业上证明其价值。商业模式的设计应紧密围绕其为客户创造的ROI。

价值量化。清晰地向客户展示Agent带来的效率提升(节省工时)、成本下降(减少人力)、风险降低(避免损失)。

灵活的定价模型。可以根据不同场景,采用按席位(SaaS)、按调用量(Pay-as-you-go)或按效果(Value-based)的定价策略。

绑定业务流程。将Agent嵌入客户的关键业务流程节点,与核心KPI挂钩,从而实现高粘性和持续复购。

结论

AI Agent的落地之路,是一次从技术狂热到商业理性的回归。成功的范式已经清晰,它不属于追求无所不能的“万能助手”,而属于那些愿意沉下心来,聚焦单一场景、深耕行业需求的“数字专才”。

这条路没有捷径。它要求产品团队既要有仰望星空的想象力,更要有脚踏实地的工程能力和运营耐心。我们需要为Agent精心设计它的“岗位”,清醒认识它的“边界”,用严谨的工程体系为它搭建“护栏”,并通过持续的运营迭代让它不断“成长”。

最终,AI Agent的未来,不在于人机对立或完全替代,而在于深度融合与价值共创。当我们将Agent视为一个可靠、可控、值得信赖的数字同事时,一场真正的生产力革命才刚刚开始。

📢💻 【省心锐评】

抛弃“万能”幻想,拥抱“专才”定位。AI Agent的成功,是场景、工程与运营的胜利,而非模型参数的竞赛。为Agent写好“岗位说明书”,是其从Demo走向价值的第一步。

.png)

%20%E6%8B%B7%E8%B4%9D.jpg)

评论