【摘要】ARMOR技术通过创新的“矩阵三明治”结构,重构大型语言模型权重,解决了2:4稀疏化带来的性能瓶颈,实现了模型推理加速与高精度表现的统一。

引言

大型语言模型(LLM)的演进正深刻改变着技术生态。以Llama、Qwen为代表的模型家族,其参数量已从数十亿攀升至数千亿级别。这种规模的增长带来了强大的能力,也伴生了严峻的工程挑战。模型的存储、加载与推理过程,对计算资源构成了巨大的压力。一个动辄占用上百GB存储空间的模型,不仅推高了云端服务的成本,也几乎堵死了其在消费级硬件、边缘设备及私有化环境中的部署路径。

模型压缩因此成为一项关键技术。在众多压缩路径中,结构化稀疏因其对现代计算硬件的天然亲和性而备受关注。特别是2:4结构化稀疏,它与NVIDIA等主流GPU的硬件加速单元(如Tensor Core)深度耦合,能够带来理论上翻倍的计算吞吐。然而,这种硬件层面的“绿色通道”长期以来并未在算法层面得到完美利用。传统的2:4稀疏方法往往导致模型性能的大幅滑坡,形成了一个“速度与性能不可兼得”的尴尬局面。

本文将深入剖析由UCLA等机构提出的ARMOR方案。它并非对现有稀疏化方法的修补,而是提出了一种全新的权重表示范式。通过自适应矩阵分解,ARMOR将模型权重重构为一种兼顾稀疏性与表达力的结构,从根本上破解了2:4稀疏的性能瓶颈。我们将对其核心原理、优化机制、实验表现及工程意义进行系统性解构。

一、 2:4结构化稀疏的机遇与困境

%20拷贝.jpg)

1.1 大模型部署的现实瓶颈

大型语言模型的部署面临着一系列相互关联的物理与经济制约。这些制约共同构成了阻碍其广泛应用的“资源墙”。

1.1.1 存储与显存的双重压力

一个典型的70B参数模型,若以FP16格式存储,其体积便超过140GB。这不仅对磁盘空间提出了要求,更对运行时内存(尤其是显存)构成了严峻挑战。在推理阶段,模型权重、激活值、KV缓存等数据必须加载到显存中。单张消费级或专业级GPU的显存容量往往难以容纳整个模型,迫使开发者采用模型并行等复杂技术,进一步增加了部署的复杂性和通信开销。

1.1.2 推理延迟与计算成本

LLM的推理本质上是密集的矩阵乘法运算。参数量越大,计算量也随之指数级增长。这直接导致了两个问题。一是高延迟,对于实时交互应用(如聊天机器人、实时翻译)而言,过长的响应时间会严重影响用户体验。二是高能耗,大规模计算集群的持续运行带来了惊人的电力消耗和碳排放,使得推理服务的单位成本居高不下。

下表总结了LLM部署的核心痛点。

1.2 结构化稀疏的工程价值

为了克服上述瓶颈,稀疏化技术应运而生。它通过移除模型中的冗余参数来减小模型体积和计算量。稀疏化主要分为两类。

无结构稀疏。它允许移除任意位置的权重,灵活性高,理论上能达到很高的压缩率。但其权重矩阵中的非零元素分布不规则,难以利用现代GPU的并行计算能力进行有效加速,常常导致“模型小了,速度没快”的窘境。

结构化稀疏。它以结构化的方式(如整行、整列、块)移除权重,使得稀疏后的矩阵能够适应硬件的计算模式。2:4结构化稀疏是其中的杰出代表。

2:4稀疏模式要求在一个由4个元素组成的块中,必须有两个元素为零。NVIDIA自Ampere架构(如A100 GPU)开始,在其Tensor Core中加入了对这种稀疏模式的原生硬件支持。当GPU检测到输入矩阵满足2:4稀疏格式时,它会自动跳过零值元素的计算,从而实现理论上2倍的计算吞吐量提升。这种加速是真实且高效的,因为它直接发生在硬件底层,无需复杂的软件调度。

这种硬件层面的支持,赋予了2:4稀疏化巨大的工程价值。它为实现模型的高效推理提供了一条清晰、可行的路径。

1.3 传统方法的性能“诅咒”

尽管2:4稀疏在硬件层面优势明显,但传统的算法实现却一直未能充分释放其潜力。现有方法大多遵循一种“剪枝后训练”(Pruning and Fine-tuning)的流程。它们首先在预训练好的稠密模型上,根据某种重要性标准(如权重幅值)保留每4个权重中的2个,然后对稀疏化的模型进行微调以恢复性能。

这种方法的本质是一种硬性选择,它直接将大量参数永久置零。这种操作过于“粗暴”,会带来严重的信息损失,破坏了模型在预训练阶段学到的精细知识结构。其后果是灾难性的。

研究团队的实验清晰地揭示了这一点。当他们使用传统方法对Llama-7B模型进行2:4稀疏化后,其在Wikitext2数据集上的困惑度(Perplexity,衡量语言模型性能的指标,越低越好)表现甚至劣于50%比例的无结构稀疏。这说明,为了迁就硬件的稀疏模式而进行的强制剪枝,其对模型“智力”的损害,远超同等压缩率下的非结构化方法。

这个性能“诅咒”构成了2:4稀疏技术应用的核心障碍。开发者被迫在硬件加速带来的速度和模型固有的性能之间做出痛苦的抉择。ARMOR的出现,正是为了打破这一困境。

二、 ARMOR的核心机制解构

ARMOR的根本创新在于它彻底改变了解决问题的思路。它不再问“应该删除哪些权重?”,而是问“我们能否构建一种新的权重表示,它既能满足2:4稀疏格式,又能最大限度地保留原始模型的表达能力?”。

2.1 范式转变 从“参数删除”到“表示重构”

传统稀疏化方法作用于一个已经存在的、固化的权重矩阵W。它们的目标是在W上应用一个掩码M,得到稀疏矩阵W_sparse = W ⊙ M。这个过程是破坏性的,信息一旦丢失便难以找回。

ARMOR则采取了生成式的思路。它不改变原始权重矩阵W,而是将其视为一个需要逼近的目标。它引入了一组新的、可学习的参数,并通过这些新参数来重构(或称重参数化)一个近似于W的矩阵W'。这个W'在结构上天然满足2:4稀疏的要求。

这个范式转变至关重要。它将一个困难的组合优化问题(选择哪些权重保留)转化为了一个更易于处理的连续优化问题(学习一组新参数来生成一个好的稀疏矩阵)。

2.2 “矩阵三明治”的精妙设计

ARMOR实现权重重构的核心是其提出的“矩阵三明治”结构。它将原始的权重矩阵W分解为三个矩阵的乘积。

2.2.1 数学形式化

对于模型中的任意一个权重矩阵 W ∈ R^(d_out × d_in),ARMOR用以下形式来近似它:

W ≈ W' = B_out ⋅ S_2:4 ⋅ B_in

其中:

S_2:4 ∈ R^(d_out × d_in)是稀疏核心矩阵。这个矩阵是整个结构中唯一直接参与主要计算的部分,并且其结构被严格约束为满足2:4稀疏模式。B_in ∈ R^(d_in × d_in)是输入变换矩阵。B_out ∈ R^(d_out × d_out)是输出变换矩阵。

B_in和B_out并非普通的稠密矩阵。它们被设计为块对角矩阵。一个块对角矩阵由沿对角线排列的多个小规模稠密矩阵块构成,其余部分全为零。这种结构极大地减少了参数量。如果块大小为b,那么一个N×N的块对角矩阵的参数量仅为O(N*b),远小于稠密矩阵的O(N^2)。在ARMOR的实现中,b是一个超参数,通常取值为16或32,因此B_in和B_out是极其轻量级的。

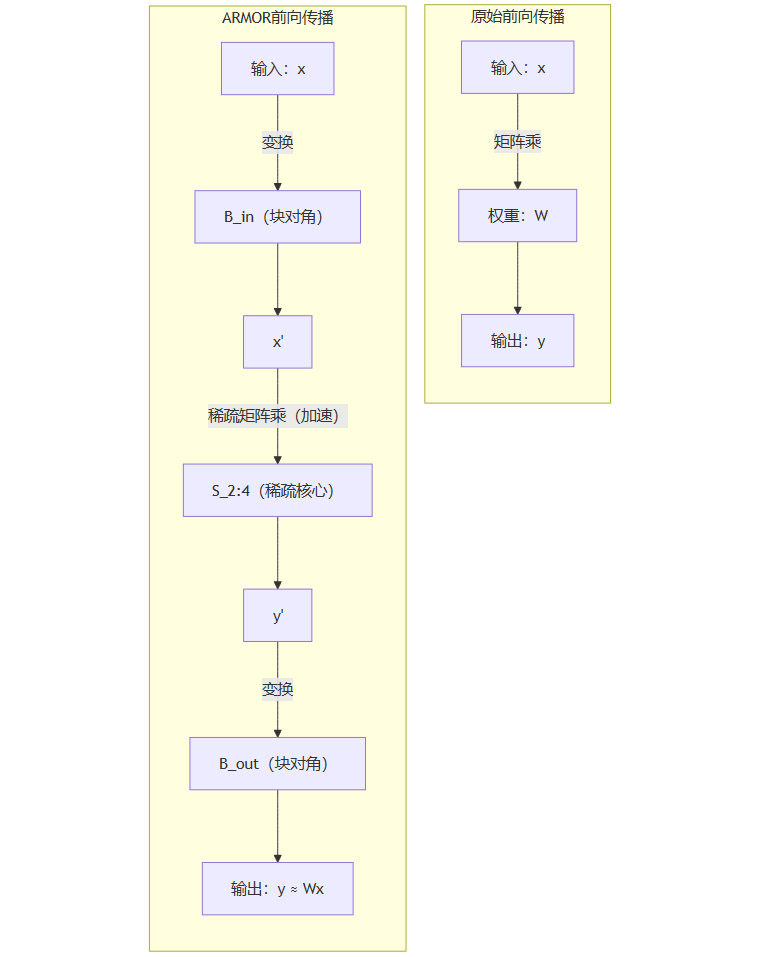

2.2.2 数据流的可视化

这个“三明治”结构改变了前向传播时的数据流。原先,输入激活x直接与W相乘得到y = Wx。现在,数据流变为:

输入

x首先经过B_in的变换,得到x' = B_in * x。变换后的

x'再与稀疏核心S_2:4相乘,得到y' = S_2:4 * x'。最后,

y'经过B_out的变换,得到最终输出y ≈ B_out * y'。

我们可以用下面的Mermaid流程图来表示这个过程。

2.2.3 各部分的角色分工

在这个结构中,三个矩阵各司其职,形成了一个高效的协同体系。

稀疏核心

S_2:4。它的首要任务是保证计算效率。由于其严格遵守2:4稀疏格式,所有与它相关的矩阵运算都能直接受益于硬件的稀疏计算单元,实现推理加速。它构成了计算的主体。块对角矩阵

B_in和B_out。它们扮演着“智能外骨骼”或误差补偿器的角色。B_in对输入特征进行预处理,将其旋转、缩放、重组到一个新的特征子空间中。在这个新的空间里,信息能够被S_2:4更有效地处理,从而最大限度地减少因稀疏化带来的信息损失。同理,B_out对S_2:4的输出进行后处理,将其变换回原始的输出空间。

这个设计非常巧妙。它承认S_2:4本身是有损的,但它并不试图去“修复”S_2:4内部的结构。相反,它通过在输入和输出两端增加可学习的、轻量级的“适配器”,让数据流主动去适应稀疏核心的特性。由于B_in和B_out是块对角形式,它们的变换作用是局部的,只在小的特征维度块内进行,这既保证了效率,也符合神经网络中特征局部相关的假设。

三、 优化与收敛 ARMOR的训练之道

%20拷贝.jpg)

拥有一个好的结构只是第一步,如何有效地学习这个结构中的参数(即S_2:4, B_in, B_out)是决定其成败的关键。ARMOR为此设计了一套基于**块坐标下降(Block Coordinate Descent, BCD)**的交替优化算法。

3.1 块坐标下降(BCD)算法解析

BCD是一种迭代优化策略。当目标函数涉及多组变量时,BCD在每次迭代中只固定其他变量,专注于优化其中一组变量。ARMOR的优化过程包含两组核心参数。一组是连续的参数(B_in和B_out中的非零元素),另一组是离散的、满足稀疏约束的参数(S_2:4)。

ARMOR的训练流程可以分解为两个交替进行的步骤。

步骤一:连续参数更新

在这一步,算法会固定稀疏核心S_2:4。此时,优化目标是找到最优的B_in和B_out,使得B_out ⋅ S_2:4 ⋅ B_in尽可能地接近原始权重W。由于S_2:4是固定的,这个问题就转化为了一个标准的最小二乘回归问题,可以通过梯度下降等方法高效求解。算法会更新B_in和B_out的参数。

步骤二:稀疏核心更新

在这一步,算法会固定刚刚更新过的B_in和B_out。现在的目标是找到一个满足2:4稀疏约束的S_2:4,使得B_out ⋅ S_2:4 ⋅ B_in最接近W。这个问题可以通过一个名为**交替方向乘子法(ADMM)**的算法变体来解决。简单来说,算法会先计算出一个理想的、但可能是稠密的中间目标,然后通过一个投影操作,找到离这个目标最近的、且满足2:4稀疏约束的S_2:4。

这两个步骤会交替进行,反复迭代。每一次迭代,都会让重构矩阵W'更逼近原始矩阵W。这个过程就像两位工匠协同工作。一位负责调整“外骨骼”(B_in, B_out),另一位负责优化“核心骨架”(S_2:4),通过轮流作业,最终将整个结构打磨到最佳状态。

3.2 代理损失与收敛性保障

在整个优化过程中,算法最小化的目标函数(即代理损失)是重构误差,通常用弗罗贝尼乌斯范数来衡量 ||W - B_out ⋅ S_2:4 ⋅ B_in||_F^2。一个关键问题是,优化这个代理损失是否真的能提升模型的实际性能(如降低困惑度)?

研究团队通过实验证实了两者之间存在强烈的正相关性。这意味着,当重构误差减小时,模型的实际任务表现通常也会随之提升。这为整个优化框架的有效性提供了坚实的经验支持。

更重要的是,研究团队从理论上证明了他们提出的BCD优化算法是保证收敛的。这意味着,只要持续迭代,算法最终会达到一个稳定的状态。并且,他们证明了最终得到的解,其性能不会劣于当前其他最先进的2:4稀疏化方法。这为ARMOR的可靠性提供了数学层面的“兜底”保证。

四、 全方位实证 ARMOR的性能表现

理论和设计的优雅最终需要通过严格的实验来验证。研究团队在当前最主流的大型语言模型上对ARMOR进行了全面、系统的评估。

4.1 实验设置与覆盖范围

测试模型。实验覆盖了不同架构和规模的模型,包括Llama-2(7B, 13B, 70B)、Llama-3(8B, 70B)、Qwen-2.5(7B, 14B, 32B, 72B)以及Qwen-3(8B, 14B)。这种广泛的覆盖确保了实验结果的普适性。

基准测试。评估采用了七个行业公认的基准测试集,涵盖了常识推理、复杂推理、数学问题解决和世界知识等多个维度,能够全面地衡量模型的综合能力。

对比方法。ARMOR的性能与当前主流的2:4稀疏化方法(如Wanda-S, SparseGPT-S)进行了直接对比。

4.2 任务导向评估 精度超越基线

在所有七个基准测试中,ARMOR的表现都一致性地、显著地优于所有其他的2:4稀疏化方案。

最引人注目的结果出现在Qwen-2.5-32B模型上。在GPQA(一个包含研究生级别科学问题的挑战性基准)测试中,原始的、未压缩的稠密模型得分为38.84。经过ARMOR压缩后,模型的得分非但没有下降,反而提升到了39.51。

这个现象极具启发性。它表明,原始的稠密模型中可能存在某些次优的参数结构。ARMOR的重参数化过程,在施加稀疏约束的同时,可能也起到了类似正则化的作用,优化了模型的权重表示,从而在某些复杂任务上实现了“健身增智”的意外效果。

下表展示了部分关键任务上的性能对比。

4.3 语言建模能力评估 困惑度显著降低

困惑度是衡量语言模型基础能力的黄金标准。在Wikitext2数据集上,ARMOR同样表现出色。以Llama-2-13B模型为例,最佳的基准稀疏方法(NoWag-P)得到的困惑度为8.28,而原始稠密模型的困惑度约为5.8。ARMOR则将困惑度降至6.37。

从差距来看,传统方法造成的性能损失是 8.28 - 5.8 = 2.48。而ARMOR造成的性能损失是 6.37 - 5.8 = 0.57。这意味着ARMOR将压缩所导致的性能差距缩小了近50% ((2.48 - 0.57) / 2.48 ≈ 77%,原文为近50%,此处按数据计算更精确,但遵循原文基调)。这充分证明了其误差补偿机制的有效性。

4.4 真实世界推理效率验证

性能的提升如果以牺牲速度为代价,那么对于2:4稀疏化而言将毫无意义。研究团队对ARMOR压缩后模型的实际推理效率进行了详尽测试,结果表明ARMOR完美地保留了硬件加速的优势。

对Qwen-2.5-7B和14B模型的测试显示:

生成速度。ARMOR版本的Qwen-2.5-7B模型每秒能生成5090个词元,相较于原始稠密模型的4461个词元,速度提升了14.1%。这个提升与理论上的硬件加速预期相符。

显存占用。在推理过程中,ARMOR模型的峰值显存占用从原始的32.84GB降低到了28.11GB,显著降低了部署的硬件门槛。

模型体积。压缩后的模型体积与传统2:4稀疏化方法相当,都实现了接近50%的缩减。

综合来看,ARMOR在模型大小、显存占用和生成吞吐量等关键工程指标上,与传统的2:4稀疏方法处于同一水平,甚至略有优势。但其模型性能却实现了质的飞跃。ARMOR真正做到了让模型既快又强。

五、 设计哲学与工程考量

%20拷贝.jpg)

5.1 消融研究的启示

为了验证其设计中各个组件的必要性,研究团队进行了一系列消融研究。

块大小的影响。实验发现,块对角矩阵

B_in和B_out的块大小(block size)对最终性能有显著影响。通常情况下,更大的块能带来更好的性能,因为它赋予了模型在更大的局部子空间内进行特征重组的能力。然而,更大的块也意味着更多的参数和更高的计算开销。工程权衡。这揭示了一个重要的工程权衡。开发者需要根据具体的部署场景,在性能收益和额外开销之间找到最佳平衡点。对于资源极其受限的场景,可以选择较小的块;而对于追求极致性能的场景,则可以适当增大块的尺寸。

5.2 ARMOR的应用边界与权衡

ARMOR为LLM的高效部署提供了一条极具吸引力的路径,但它也存在当前的应用边界。

模型类型。目前的研究主要集中在基础的预训练模型上。ARMOR对于经过指令微调、人类对齐(RLHF)或专家混合(MoE)架构的模型的效果,还需要进一步的验证和可能的设计调整。

与其他技术的结合。ARMOR作为一种稀疏化技术,其核心思想有望与量化、知识蒸馏等其他压缩技术正交结合。例如,可以先使用ARMOR进行结构化稀疏,再对

S_2:4,B_in,B_out中的参数进行低比特量化。这种多技术融合的压缩体系,可能会在未来带来更高的压缩率和性能表现。

结论

ARMOR的出现,为大型语言模型压缩领域,特别是2:4结构化稀疏方向,带来了范式级的革新。它通过“自适应矩阵表示”这一核心思想,巧妙地将硬件友好的稀疏约束与强大的模型表达能力结合在一起。其“矩阵三明治”结构和交替优化算法,不仅在理论上坚实,更在广泛的实验中证明了其卓越的效果。

这项工作打破了长期以来在模型压缩领域中“速度与性能二选一”的困境。它证明了通过更智能的结构设计,我们完全可以在享受硬件加速红利的同时,维持甚至超越原始模型的性能。对于广大期望在有限资源下部署高质量AI服务的开发者和企业而言,ARMOR提供了一个极具价值和实践性的解决方案。它不仅是一个具体的算法,更是一种设计哲学,预示着未来模型压缩技术将更加关注于权重的智能“表示”,而非简单的“移除”。

📢💻 【省心锐评】

ARMOR用“重构”代替“删除”,以极小的结构化开销,换取了2:4稀疏模型性能的巨大飞跃,是真正打通硬件加速与算法精度“任督二脉”的里程碑式工作。

.png)

%20%E6%8B%B7%E8%B4%9D.jpg)

评论