【摘要】AI代理的首次年度绩效评估揭示了其并非即插即用的完美员工。报告总结了六大核心教训,强调企业需从重塑工作流、明确分工、持续培养、内置监控、模块化复用及人机协同六个维度系统推进,才能避免陷阱,实现价值。

引言

AI代理(Agentic AI)已经悄然走进我们的工作场所,成为名副其实的“数字同事”。既然是同事,它们自然也逃不过年度绩效评估。最近,麦肯锡团队就开创先河,公布了对内部署的一批AI代理为期一年的绩效评估结果。

这份报告像一面镜子,照出了AI代理光鲜外表下的真实面貌。结论并不令人意外,却足够发人深省。这些数字员工要真正跟上人类的工作节奏,还有很长的路要走。并非所有业务场景都适合它们大展拳脚。更重要的是,它们的人类同事,对这些新伙伴的工作表现也并非全然满意。

这份评估报告由麦肯锡的Lareina Yee、Michael Chui和Roger Roberts等人主笔,凝结了他们在超过50个AI代理项目中的实践与反思。它不是一份冰冷的技术文档,更像是一本写满了经验与教训的航海日志。它告诉我们,在驾驭AI代理这艘大船时,哪里有暗礁,哪里有捷径。

接下来,我们将深入剖析这份报告揭示的六大核心教训,并融合业界前沿的工程化思考,为您呈现一幅AI代理从“概念炫技”到“价值落地”的全景路线图。这不仅是技术的探讨,更是对未来工作模式的一次深度预演。

🎯 一、重塑工作流,而非为AI而AI

%20拷贝-cfnb.jpg)

部署AI代理时,最容易陷入的误区,就是为了技术而技术。许多团队被AI代理强大的自主决策能力所吸引,急于将其引入,仿佛拥有一个代理就等于迈入了智能化的未来。这是一种本末倒置。

成功的AI代理项目,无一例外,都始于对业务流程的深刻理解与彻底重塑。其核心目标不是简单地用AI替换某个环节,而是让整个端到端的工作流变得更高效、更稳定、更可控。

1.1 从“痛点地图”开始

在编写任何一行代码之前,首要任务是绘制业务流程的“痛点地图”。这意味着需要召集业务专家、一线员工和技术人员,共同将一个完整的业务流程拆解到最细颗粒度,然后逐一识别出那些耗时最长、错误率最高、最让员工感到沮丧和重复枯燥的环节。

以一个典型的保险理赔流程为例,它可能包含以下步骤。

通过这张“痛点地图”,我们可以清晰地看到,AI代理并非要全盘接管,而是应该像一把精准的手术刀,切入流程中最需要被优化的环节。例如,在上述理赔流程中,AI代理在材料处理、信息提取和报告生成等环节能发挥巨大价值,而最终的定损决策和客户沟通,则依然需要人类专家的智慧与共情能力。

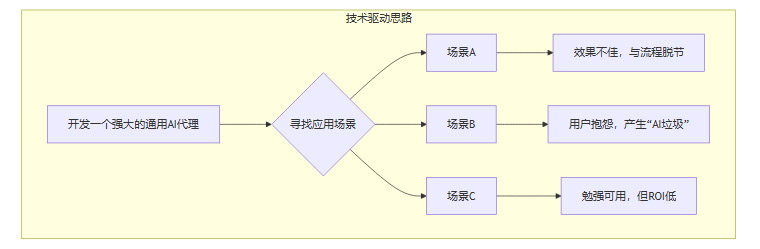

1.2 两种截然不同的部署思路

基于是否以工作流为中心,企业在部署AI代理时会走向两条完全不同的道路。

思路一:技术驱动的“孤岛式”部署

这种思路的起点通常是“我们有一个很酷的AI代理技术,能用它来做什么?”。团队可能会开发一个功能强大的通用代理,然后尝试将其应用到各种看似合适的场景中。

这种方式的后果往往是灾难性的。由于代理的设计与具体业务流程脱节,它可能无法理解上下文,输出不准确,或者需要用户进行大量额外的手动调整。最终,代理不仅没有提升效率,反而成了新的负担,被一线员工贴上“AI垃圾”的标签后束之高阁。

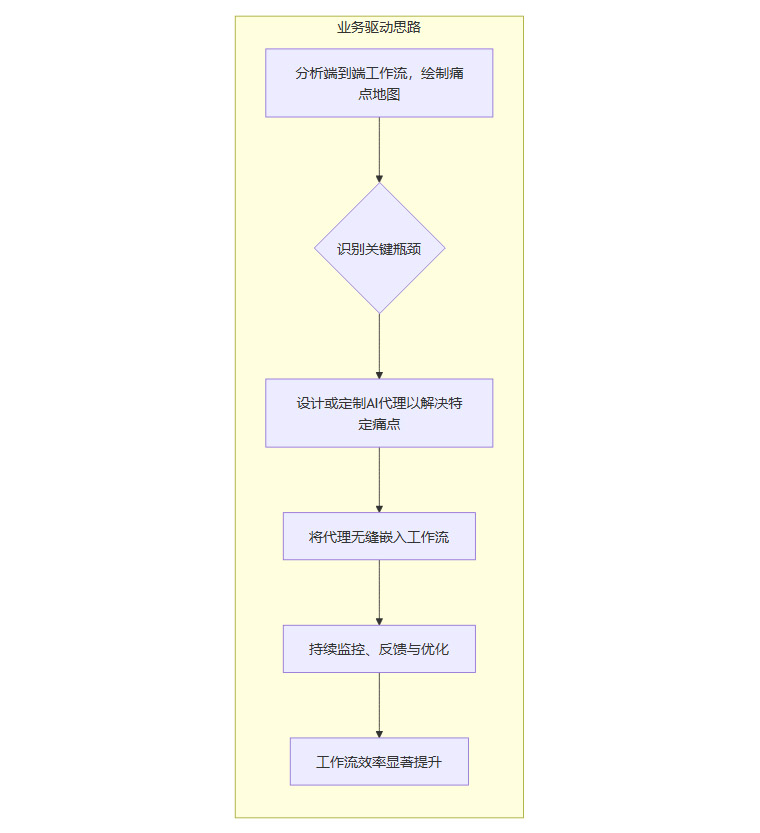

思路二:业务驱动的“融入式”部署

这种思路的起点是“我们的业务流程中存在什么问题?AI代理能否帮助解决?”。团队会先进行彻底的流程分析,然后设计或选择最适合该特定流程的AI代理。

在这种模式下,AI代理从诞生之初就是工作流的一部分。它的目标明确,职责清晰。因为它专注于解决一个具体、真实的问题,其输出的价值更容易被衡量,也更容易获得用户的信任和支持。这种“小处着手,融入流程”的方式,才是AI代理落地的正确姿态。

🧩 二、明确分工,知人善任

将AI代理引入团队,就像招聘一位新员工。管理者需要思考的第一个问题是,这个新员工的优势是什么?他适合做什么岗位?团队里现有的其他成员(包括人类员工和其他自动化工具)又该如何与他配合?

一个常见的误区是,将AI代理视为解决所有自动化需求的“万能钥匙”。实际上,对于不同类型和复杂度的任务,技术选型有着天壤之别。盲目地用AI代理去处理那些本可以用更简单工具解决的问题,是一种典型的“过度工程化”,会造成巨大的资源浪费。

2.1 自动化技术的“场景分流”策略

企业应该建立一套清晰的**“场景分流”策略**,根据任务的特性,将其分配给最合适的技术工具。这就像一个交通枢纽,将不同的车流引导至最合适的道路。

以下表格详细对比了四种主流自动化技术及其适用场景。

从上表可以看出,这四种技术并非竞争关系,而是互补关系。

如果一个任务只是“将A系统的数据复制到B系统”,那么RPA是最佳选择。

如果任务是“预测哪个客户下个月可能会流失”,那么预测分析模型更胜一筹。

如果只是需要“帮我把这段会议记录总结成三点”,一个简单的LLM提示就足够了。

只有当任务是“请调研一下我们主要竞争对手最近三个月的市场活动,分析他们的策略变化,并生成一份包含数据图表的PPT报告初稿”时,AI代理的价值才能真正凸显。因为这个任务需要代理自主地进行网络搜索、阅读分析报告、调用数据分析工具、使用PPT生成工具等一系列复杂动作。

2.2 像组建高绩效团队一样评估代理

在决定是否使用AI代理时,管理者应该问自己以下几个问题,这与组建一个高绩效的人类团队并无二致。

需要完成的工作(Job to be Done)是什么? 必须用最清晰的语言定义任务的目标和交付标准。

团队中每个成员的相对优势是什么?

人类员工的优势在于创造力、战略性思维、复杂判断、共情能力和处理未知异常情况。

AI代理的优势在于高速处理信息、执行多步指令、不知疲倦地工作和调用各种数字工具。

其他自动化工具(如RPA)的优势在于稳定、低成本地执行固定规则。

如何设计协作流程,让大家各展所长? 应该让AI代理承担繁琐、重复但又需要一定智能的中间环节,将人类员工从这些工作中解放出来,专注于更高价值的决策和创新。

例如,在一个内容创作团队中,一个理想的人机协作流程可能是这样的。

人类策略师 提出内容主题和方向。

AI代理 负责收集相关资料、进行初步的事实核查、生成内容大纲和初稿。

人类创作者 在代理生成的初稿基础上,进行深度的内容优化、风格润色和创意升华。

人类编辑 进行最终的审校和发布。

在这个流程中,AI代理不是要取代创作者,而是成为了创作者的“超级助理”,极大地提升了内容生产的效率和广度。这种基于优势互补的“知人善任”,才是成功引入AI代理的关键所在。如果让代理去负责最终的创意决策,或者让人类员工继续手动整理资料,都是对资源的错配。

🌱 三、持续培养,杜绝“AI垃圾”

%20拷贝-fmxx.jpg)

许多AI代理项目都经历过一个令人沮ICC的阶段。在精心准备的演示中,代理表现得无所不能,赢得了满堂喝彩。可一旦交到实际负责工作的用户手中,它就开始频繁“犯傻”,输出各种不着边际、质量低劣的内容。这些输出被用户无奈地称为**“AI垃圾”**。

“AI垃圾”的出现,是导致用户对代理失去信任、并最终放弃使用的首要原因。它标志着一个AI代理项目从“看起来很美”到“实际上手很难用”的转折点。要避免这种情况,就必须摒弃“一劳永逸”的幻想,像培养一名新员工那样,对AI代理进行持续的投入和培养。

3.1 为代理建立“员工成长档案”

一个成功的AI代理,背后必然有一套完善的“成长体系”。这套体系应该包含以下几个核心要素。

明确的岗位描述(Job Description)

在代理开发之初,就应该为其撰写一份清晰的“岗位描述”。这份文档需要明确定义代理的职责范围、核心任务、绩效目标(KPIs)以及禁止行为。例如,一个用于客户支持的代理,其岗位描述可能包括“负责解答关于产品功能的常见问题”、“KPI为首次问题解决率达到80%”、“禁止回答任何与价格或折扣相关的问题”。这份文档是后续所有开发、测试和优化的基石。系统的入职培训(Onboarding)

代理的“入职培训”就是高质量数据的喂养和基于业务场景的微调(Fine-tuning)。这不仅仅是简单地将公司文档库丢给模型。更重要的是,需要由领域专家精心筛选和标注一批具有代表性的“教学案例”(Exemplars),让代理学习在真实业务场景下,什么是“好的回答”,什么是“坏的回答”。持续的绩效反馈(Performance Feedback)

代理上线后,工作才刚刚开始。必须建立一个闭环的反馈机制,让用户能够方便地对代理的每一次输出进行评价。最简单的反馈可以是“赞”或“踩”,更复杂的可以包括错误分类、修改建议等。这些来自一线的真实反馈,是代理持续迭代和进化的最宝贵养料。

3.2 建立端到端的评测体系

对AI代理的评估,绝不能仅仅停留在“感觉上好用”或“演示效果不错”。需要建立一套贯穿其整个生命周期的、量化的、多维度的评测体系。这个体系应该覆盖从开发测试到线上监控的全过程。

以下表格展示了一个相对完善的AI代理评测指标体系。

专家标注校准在这一体系中扮演着至关重要的角色。在代理上线前和运行中,都需要定期邀请领域专家,对代理的输出进行“盲审”和打分。专家的判断是衡量模型输出质量的“金标准”,可以用来校准自动化评估指标的偏差,并发现模型在特定业务知识上的盲点。

例如,一个法律咨询代理可能在语言上非常流畅,但如果它错误地引用了某个法条,只有法律专家才能发现这个致命的错误。没有专家的持续介入,代理的“专业性”就无从谈起,其输出的“AI垃圾”可能会带来灾难性的法律风险。

🔬 四、全流程监控,为规模化护航

当企业只部署一两个AI代理时,发现和修正错误相对容易。几位工程师盯着日志,或者用户直接反馈问题,就能快速定位。然而,当代理的数量从个位数增长到成百上千,并深度嵌入到企业的核心业务流程中时,这种“作坊式”的运维方式将彻底失效。

在规模化部署的背景下,一个微小的错误可能会被放大成千上万倍,造成巨大的业务损失或合规风险。更可怕的是,由于AI代理决策链条的复杂性,当问题发生时,要追溯到是哪一个代理、在哪一个步骤、基于什么信息做出了错误决策,将变得异常困难。这就是所谓的“无声失败”(Silent Failure)。

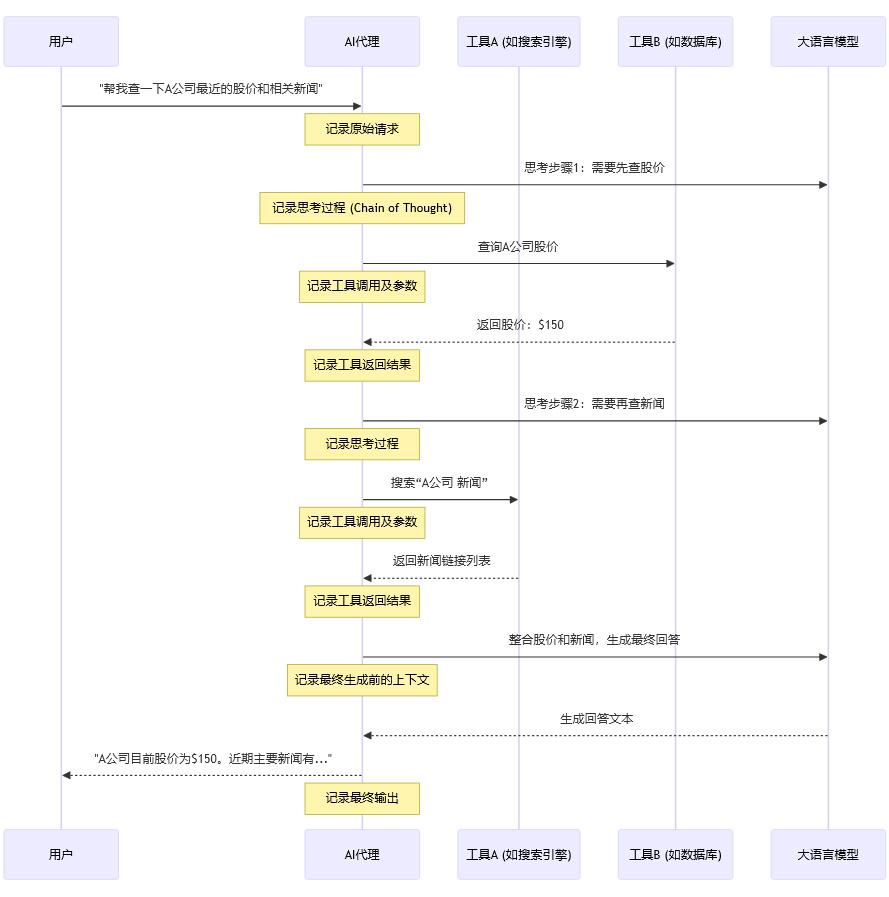

为了应对这一挑战,必须从一开始就将**全流程的可观测性(Observability)**作为系统设计的核心原则,为未来的规模化部署铺平道路。

4.1 从“日志”到“可观测性”的思维转变

传统的系统监控主要依赖日志(Logs)、指标(Metrics)和追踪(Traces)。但在AI代理的场景下,这还远远不够。我们需要的是一种更深层次的“可观测性”,它不仅要回答“系统是否出错了?”,更要能回答“系统为什么会这样决策?”。

这意味着我们需要记录和追踪AI代理决策的全过程。

上图展示了一个简化的AI代理工作流。一个具备良好可观测性的系统,需要将图中所有“Note”标注的环节都完整地记录下来,并将其关联到同一个任务ID下。这样,当用户反馈某个结果不准确时,工程师就能像播放录像一样,完整回溯代理的每一步思考和行动,快速定位问题根源。

4.2 建立分步可观测性与“调试台账”

为了实现上述目标,企业需要构建一个**“AI代理调试台账”**(或称为“AI代理运维中心”)。这个平台的核心功能是串联起日志、指标、数据样本和人工复盘的完整链路。

这个“调试台账”是AI代理能够安全、可靠地进行规模化部署的“安全带”和“黑匣子”。没有它,盲目扩大代理的部署规模,无异于在没有仪表盘和导航系统的情况下进行夜航,风险极高。在项目初期就投入资源建设这样的基础设施,从长远来看,将获得巨大的回报。

🧱 五、模块化复用,构建代理“乐高库”

%20拷贝-hylf.jpg)

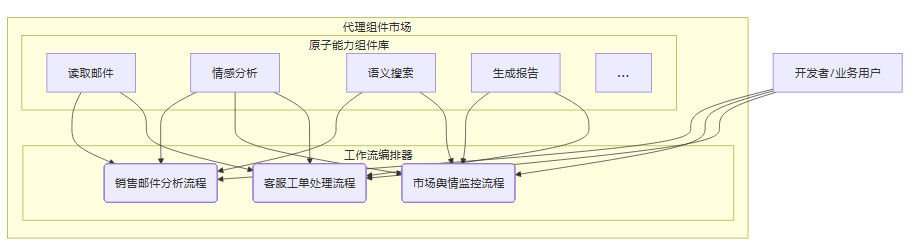

随着企业内部署的AI代理越来越多,一个新问题浮出水面:开发效率低下,系统冗余严重。许多团队发现,他们正在为不同的业务场景,反复“造轮子”,开发着功能相似的代理。

例如,销售团队需要一个代理来分析客户邮件,市场团队需要一个代理来分析社交媒体评论,客服团队需要一个代理来分析用户反馈工单。尽管业务场景不同,但这三个代理的核心能力都包含“文本情感分析”、“关键信息提取”等通用任务。如果为每个场景都从零开始开发,无疑是巨大的资源浪费。

麦肯锡的报告指出,通过识别和开发可复用的代理组件,可以将重复开发工作减少30%至50%。这背后的核心思想,是平台化与模块化。

5.1 识别可复用的“原子能力”

高效的做法是,将复杂的代理任务拆解为一系列可复用的“原子能力”或“技能”(Skills)。这些原子能力就像一块块乐高积木,可以被灵活地组合,以搭建出满足不同业务需求的、更复杂的代理。

常见的可复用原子能力包括:

数据摄取(Ingestion)

读取邮件

抓取网页

连接数据库

读取PDF/Word文档

信息提取(Extraction)

命名实体识别(人名、地名、公司名)

关键信息提取(合同金额、截止日期)

情感分析

意图识别

搜索与检索(Search & Retrieval)

在内部知识库中进行语义搜索

在互联网上进行搜索

在数据库中执行查询

分析与计算(Analysis & Calculation)

数据聚合与统计

执行数学运算

调用代码解释器

内容生成(Generation)

撰写邮件

生成报告

创建图表

调用API

5.2 打造平台化的“代理组件市场”

一旦识别出这些原子能力,下一步就是将其封装成标准化的、可被轻松调用的代理组件,并建立一个内部的“代理组件市场”或“技能商店”。

这个平台应该具备以下特点。

集中化的验证与管理

所有组件在发布前,都必须经过严格的测试和验证,确保其功能的稳定性和输出的可靠性。平台应提供统一的版本管理、权限控制和文档说明。共享的提示库(Prompt Library)

对于那些通过精心设计的提示(Prompt)来实现的技能,平台应建立一个共享的提示库。这使得优秀的提示工程经验可以在整个组织内沉淀和复用,而不是散落在各个开发者的本地文件中。标准化的接口与SDK

平台应提供标准化的API接口和多语言的SDK,让开发者可以像调用一个普通函数库一样,轻松地在自己的应用中集成这些代理组件。可组合的工作流编排器

平台还应提供一个可视化的工作流编排工具,让业务人员或开发者可以通过拖拽的方式,将不同的代理组件组合起来,快速构建出新的、端到端的自动化流程。

通过这种平台化的方式,企业可以极大地提升AI代理的开发效率和经济可持续性。开发者不再需要关心底层模型的细节,而是可以专注于业务逻辑的编排与实现。这不仅降低了AI应用的开发门槛,也确保了整个企业在AI能力建设上的一致性和高质量。

🤝 六、人机协同,人类监督不可或缺

在关于AI的讨论中,一个永恒的主题是“替代”与“协作”。AI代理的出现,再次将这个问题推向了风口浪尖。它们强大的自主性,让许多人担忧人类员工是否会变得多余。

然而,麦肯锡的报告以及所有严肃的实践都指向同一个结论:在可预见的未来,人机协同而非完全替代,才是AI代理落地的唯一可行路径。即使是最先进的代理程序,也离不开人类的监督、判断和干预。

6.1 人类在环(Human-in-the-Loop)的必要性

AI代理本质上是一个基于概率的系统,这意味着它永远存在犯错的可能。特别是在处理高风险、高价值或模糊不清的任务时,完全依赖代理的自主决策是极其危险的。因此,必须在工作流的关键节点上,设计**“人在环”**的机制。

人类的角色主要体现在以下几个方面。

监督模型准确性

AI代理可能会产生“幻觉”,即捏造事实。例如,一个用于生成研究报告的代理,可能会引用一篇根本不存在的论文。人类专家需要对其输出的关键事实进行核查,确保其准确性。确保合规与伦理

在金融、医疗、法律等受到严格监管的行业,代理的每一个决策都可能涉及合-规风险。例如,一个信贷审批代理,其决策过程必须公平、透明,不能存在歧视。人类合规官需要对代理的决策逻辑和结果进行审计,确保其符合法律法规和伦理要求。运用常识与判断力

AI代理缺乏人类所拥有的丰富常识和对复杂社会情境的深刻理解。例如,一个客服代理可以回答关于产品功能的问题,但当面对一个情绪激动、表达含糊的客户时,它可能无法理解其真实意图。这时,就需要人类客服介入,用共情和智慧来化解矛盾。处理边缘案例(Edge Cases)

任何系统都会遇到训练数据中未曾见过或极少出现的“边缘案例”。AI代理在面对这些情况时,往往会表现得不知所措或做出错误的决策。人类的作用,就是作为最后的“安全网”,处理这些代理无法应对的异常情况。

6.2 重新设计工作,而非简单叠加

成功的人机协同,不是简单地在AI代理后面安排一个“审核员”。它需要对现有的工作岗位和组织流程进行重新设计。

以法务部门为例,引入AI合同审查代理后,法务专家的工作内容会发生根本性变化。

在这种新模式下,法务专家的角色从“合同阅读者”转变为“AI的管理者”和“最终决策者”。他们的价值不再体现在重复性劳动上,而是体现在那些机器无法替代的专业判断和战略思考上。

为了实现这种转型,组织层面需要进行配套的变革,包括对员工进行新技能的培训(如如何与AI高效互动、如何解读AI的输出),以及调整绩效考核标准,鼓励员工拥抱和善用AI工具。

缺乏这种系统性的工作再设计和组织变革,即使引入了最先进的AI代理,也可能因为无法融入现有工作体系,而导致“无声失败”、错误累积和用户的最终拒绝。

总结

AI代理的首次年度绩效评估,为所有投身于这场技术浪潮的企业敲响了警钟。它告诉我们,通往智能化的道路上没有捷径。将AI代理从一个“聪明的玩具”锻造成一个“可靠的同事”,需要的是超越技术本身的系统性思考和持久努力。

回顾这六大教训——重塑工作流、明确分工、持续培养、全流程监控、模块化复用和人机协同——它们共同指向一个核心原则:务实。

企业必须摒弃对AI不切实际的幻想,以解决真实业务问题为出发点,像对待任何一项严肃的工程和管理变革一样,进行周密的战略规划、细致的流程再造、持续的资源投入和完善的治理机制。

AI代理的落地远非一蹴而就。明年的绩效评估结果,或许依然不会尽善尽美。但这并不妨碍我们满怀信心地前行。因为每一次试错,每一次迭代,都在为构建一个更智能、更高效的未来工作模式,铺设下坚实的基石。随着平台化、复用与人机协同机制的不断完善,AI代理终将成为企业数字化转型中不可或-缺的强大引擎。

📢💻 【省心锐评】

别总想着让AI当“超人”,先教会它当个合格的“实习生”。从解决一个具体痛点开始,让人与AI在流程中共同成长,这才是正道。

.png)

%20%E6%8B%B7%E8%B4%9D-leyf.jpg)

评论