【摘要】知识库分块是RAG系统的性能基石。文章系统梳理了从固定长度到后分块(Post-Chunking)的全谱系方法,深入剖析其技术权衡与适用场景,为工程选型提供决策框架。

引言

在检索增强生成(RAG)架构中,我们常常聚焦于检索算法的精妙或生成模型的强大。但一个基础却至关重要的环节,往往决定了整个系统性能的下限,那就是知识库分块(Chunking)。分块,远非简单的文本切割。它是在语义完整性、检索相关性与工程约束三者间寻求动态平衡的艺术。

一个理想的分块,能让检索系统在浩如烟海的文档中,精准定位到最相关的上下文片段,并将其“干净”地呈递给大语言模型(LLM)。反之,一个糟糕的分块策略,则会从源头上引入噪声、割裂语义,导致后续的检索与生成环节步步维艰,最终体现为答案不准确、幻觉频发。

本文将从工程实践的视角出发,系统性地梳理当前主流的分块方法谱系。我们将从最基础的固定长度切片,逐步深入到基于结构、语义乃至LLM辅助的智能分块,最终重点剖析一个正在兴起的新范式——后分块(Post-Chunking)。文章的核心不在于评判何种方法最优,而在于揭示每种方法背后的设计权衡,并提供一个清晰的选型框架,帮助技术决策者在具体业务场景中做出最合适的工程选择。

🎯 一、分块的目标与系统性影响

%20拷贝-uscp.jpg)

分块策略的选择,会对RAG系统的每一个环节产生涟漪效应。其核心目标可以归结为四点,而这些目标直接关联到系统的最终表现与成本。

1.1 适配上下文窗口

这是最直接的物理约束。LLM的上下文窗口(Context Window)是有限的。分块必须确保喂给模型的文本片段小于此限制。同时,这也意味着我们需要在有限的长度内,封装尽可能高的信息密度。

1.2 提升检索召回精度

分块的粒度直接影响检索效果。

过大的块,虽然上下文完整,但主题可能分散,包含大量与查询无关的噪声。这会稀释查询向量与目标文本的相似度,导致相关内容被“淹没”,难以被召回。

过小的块,虽然主题聚焦,但可能丢失必要的上下文。一个问题的答案可能被割裂在两个独立的块中,导致任何一个块都无法独立满足查询意图,造成召回失败。

1.3 降低生成噪声与幻觉

送入LLM的上下文质量,直接决定了生成答案的质量。一个边界清晰、语义内聚的块,能为LLM提供高信噪比的参考信息,从而生成更准确、更忠于原文的答案。相反,一个充斥着无关信息或语义碎片的块,极易误导LLM,诱发事实性错误或内容幻觉(Hallucination)。

1.4 平衡系统成本与延迟

分块策略与系统开销息息相关。

离线成本。复杂的语义分块或LLM辅助分块,会显著增加文档入库时的计算开销和处理时间。

在线成本。分块大小影响着检索阶段需要处理的向量数量和重排(Rerank)模型的计算负担。更大的块或更复杂的“后分块”策略,通常意味着更高的查询延迟(Latency)。

分块的影响贯穿RAG全链路,如下表所示。

🎯 二、主流分块方法谱系与权衡

分块方法沿着从“规则驱动”到“语义驱动”,从“离线预处理”到“在线动态处理”的路径演进。理解它们的内在逻辑与工程代价是做出正确选择的前提。

2.1 固定长度分块 (Fixed-Length Chunking)

2.1.1 工作原理

这是最朴素的分块方式。按照预设的字符数或Token数量,将文本“一刀切”成若干等长的块。为了缓解边界处语义割裂的问题,通常会设置一个重叠区域(Overlap),让相邻块之间共享一部分内容。

2.1.2 优劣分析

优点。实现极其简单,计算开销极低,处理速度飞快。作为一个稳健的基线(Baseline),在很多简单场景下表现尚可。

缺点。其核心缺陷在于无视文本的语义结构。它极有可能在句子中间、一个完整的逻辑论述中途,甚至一个单词内部进行切割,严重破坏语义完整性。

2.1.3 适用场景

对吞吐量和延迟要求极高的生产环境。

文本本身结构性弱,或语义单元非常短小(如日志、代码片段)。

作为评估更复杂分块策略性能的对照基准。

2.2 句子/段落分块 (Sentence/Paragraph Chunking)

2.2.1 工作原理

这种方法利用了语言的自然边界。通过NLTK、spaCy等自然语言处理库,识别出句子或段落的结束符,将每个句子或段落作为一个独立的块。

2.2.2 优劣分析

优点。天然地尊重了语义边界,分块后的内容在逻辑上是完整的。这对于后续的理解和生成非常有益。

缺点。块的长度方差极大。一个段落可能只有一句话,也可能长达数千字符。过长的段落仍然可能超出LLM的上下文窗口或包含多个主题,需要进一步处理。

2.2.3 适用场景

结构清晰的说明文、新闻稿、FAQ文档。

当单个句子或段落就能构成一个完整问答对的知识库。

2.3 结构/标题层级分块 (Structural/Header-based Chunking)

2.3.1 工作原理

该方法利用文档的显式结构信息,如Markdown的标题(#, ##)、HTML的标签(<p>, <h1>, <li>)、或PDF的目录层级。它将每个标题下的内容作为一个逻辑块。

2.3.2 优劣分析

优点。分块结果高度贴合文档的原始逻辑,上下文的完整性和主题的一致性极佳。检索到的块往往能提供一个完整的、有背景的答案。

缺点。强依赖于文档的规范化程度。对于格式混乱或无结构的纯文本文档,此方法完全失效。此外,解析复杂格式(如PDF、DOCX)的稳定性和准确性也是一个工程挑战。

2.3.3 适用场景

技术白皮书、API文档、法律条款、标准规范等具有良好结构化特征的文档。

2.4 递归分块 (Recursive Chunking)

2.4.1 工作原理

递归分块是一种更具适应性的策略,它试图结合结构与长度限制。它会按一个预设的优先级列表(如:\n\n -> \n -> -> '')来尝试分割文本。首先用最高优先级的分割符(如段落符)切分,如果切分后的块仍然超过预设的长度阈值,则在该块内部,使用次一级分割符(如句子符)继续递归切分,直至所有块都满足长度要求。

2.4.2 优劣分析

优点。在保持语义结构和满足窗口限制之间取得了很好的平衡。它优先尊重文档的天然边界,只在必要时进行更细粒度的切分,通用性很强。

缺点。实现逻辑相对复杂,需要精心设计分割符的优先级和长度阈值。

2.4.3 适用场景

处理长度和结构不一的长文档,是许多通用RAG场景下的首选默认策略。

2.5 语义分块 (Semantic Chunking)

2.5.1 工作原理

语义分块不再依赖固定的规则或结构,而是根据内容本身的语义相似性来决定边界。一种常见的实现是:

将文档切分为句子。

为每个句子生成Embedding向量。

计算相邻句子之间的余弦相似度。

在相似度出现显著下降的地方(即语义发生转折的地方)设置分块边界。

2.5.2 优劣分析

优点。分块的语义内聚性最高。每个块都围绕一个高度相关的主题组织,为LLM提供了极为纯净的上下文。

缺点。计算成本高昂。它需要在入库前对所有句子进行向量化和相似度计算,处理速度较慢。分块效果也强依赖于所用Embedding模型的质量。

2.5.3 适用场景

知识密集、上下文逻辑要求高的文本,如学术论文、深度分析报告。

当预算允许,且对问答质量有极高要求的场景。

2.6 LLM辅助分块 (LLM-Aided Chunking)

2.6.1 工作原理

这是质量最高但成本也最高的方法。通过精心设计的Prompt,直接利用大语言模型来对文本进行分块。例如,可以指示LLM将一段文本“按照其内在的逻辑步骤或关键主题,拆分为多个独立的、语义完整的段落”。

2.6.2 优劣分析

优点。分块质量理论上是最好的,能够处理极其复杂和非标准的文本结构,实现真正意义上的“智能分块”。

缺点。成本极高,速度极慢。通常只适用于小规模、高价值的文档,并且需要配合缓存策略使用。

2.6.3 适用场景

合规文件、标准操作程序(SOP)、专利文档等对准确性要求达到极致的场景。

2.7 分层/多粒度分块 (Hierarchical/Multi-granularity Chunking)

2.7.1 工作原理

这种策略不是只选择一种粒度,而是为同一份文档创建多种不同尺度的分块。例如,同时索引文档的摘要、段落和句子。在检索时,可以先在一个粗粒度的层级(如段落)上召回候选,然后再在其内部的细粒度层级(如句子)上进行精确定位。

2.7.2 优劣分析

优点。兼顾了召回的广度(大块)和精度(小块),对于需要整合多方面信息才能回答的复杂问题非常有效。

缺点。索引的复杂度和存储成本显著增加。检索逻辑也变得更加复杂,需要设计多阶段的检索策略。

2.7.3 适用场景

大规模、主题多样的知识库,如维基百科或大型企业知识库。

2.8 方法谱系总结

为了更直观地对比,我们将上述预分块(Pre-Chunking)方法总结如下表。

🎯 三、关键参数选型与实践建议

%20拷贝-mstx.jpg)

无论选择哪种分块方法,总有几个关键参数需要精细调校。它们的设定直接影响分块效果。

3.1 块长 (Chunk Size)

块长,通常以Token数量衡量,是最核心的参数。

通用建议。对于大多数基于Transformer的Embedding模型(上下文窗口通常为512或1024),块长设置在256到768 Tokens之间是一个比较均衡的起点。

场景微调。

问答(Q&A)场景。倾向于更小的块(如128-256 Tokens)。因为问题通常很具体,答案也相对集中,小块能提供更高的信噪比。

摘要(Summarization)场景。可以容忍更大的块(如512-1024 Tokens),因为生成摘要需要更广阔的上下文。

权衡。块长并非越大越好。即使LLM的上下文窗口很大(如32K或128K),过大的块在检索阶段仍然会因为主题稀释而表现不佳。这就是所谓的“大海捞针”问题。

3.2 重叠 (Overlap)

重叠是指相邻块之间共享的内容长度。

通用建议。一个常见的起点是块长的10%到20%。例如,对于一个512 Tokens的块,可以设置50到100 Tokens的重叠。

作用。重叠的核心作用是保证语义的连续性。它确保了在块边界处被切断的句子或逻辑,能在下一个块中得到延续,避免了信息的丢失。

场景微调。如果文本的语义转折非常频繁和突然,可以适当加大重叠比例。但过多的重叠会增加索引的冗余和存储成本,需要权衡。

3.3 递归阈值与最小单元

对于递归分块,需要设定各层级分割符的优先级和长度阈值。

分割符优先级。一个合理的优先级顺序是:章节/标题 -> 段落 -> 句子 -> 固定长度。这确保了算法总是优先尝试在最自然的语义边界进行切分。

最小语义单元。应确保即使在最坏的情况下,切分也不会破坏一个最小的语义单元(如一个完整的句子)。

🎯 四、新范式:后分块(Post-Chunking)深度解析

前面讨论的所有方法,都遵循“先分块,后Embedding”的预分块(Pre-Chunking)模式。这种模式的根本局限在于,一旦分块完成,每个块的向量表示就只基于其内部的文本,全局上下文信息永久性丢失了。

后分块,也被称为延迟分块(Late Chunking)或“先Embedding再分块”,试图颠覆这一流程,从根本上解决上下文丢失的问题。

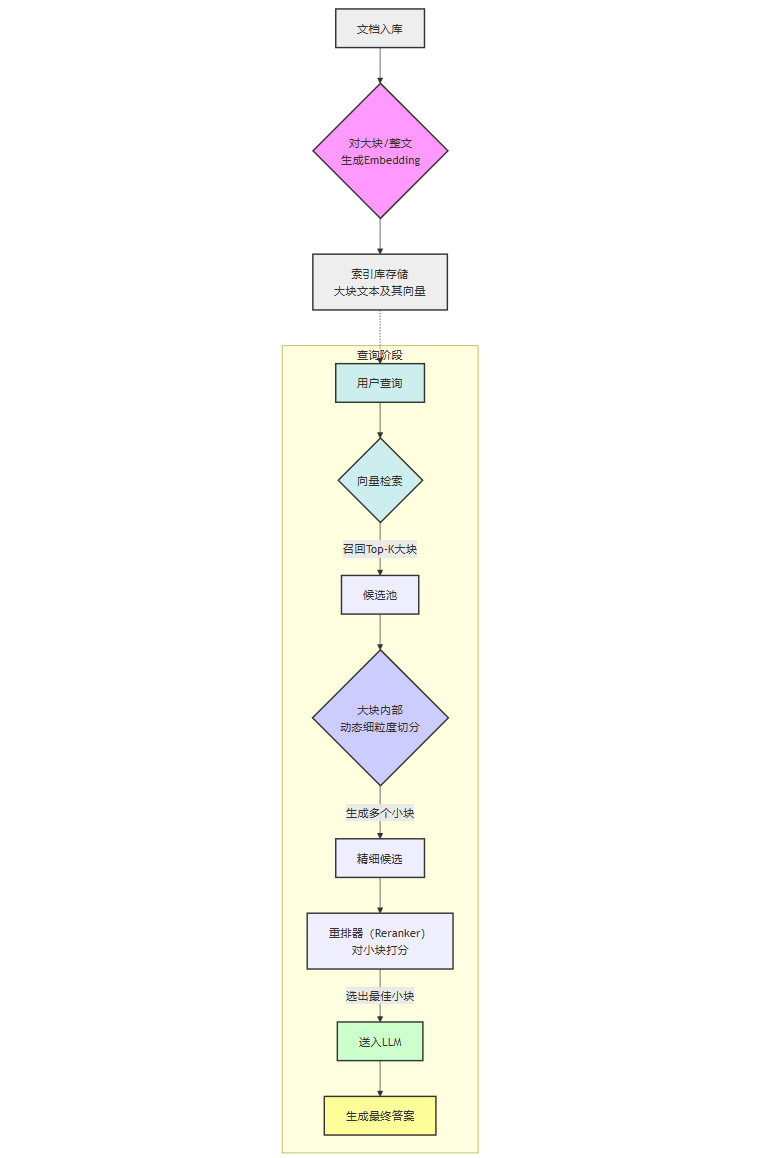

4.1 后分块的工作流

后分块将分块操作从离线的索引阶段,推迟到了在线的查询阶段。其典型工作流可以用下面的流程图表示。

核心步骤解读:

入库阶段。不再对文档进行精细切分。而是将整个文档或一个很大的逻辑部分(如一个章节)作为一个单元,使用支持长上下文的Embedding模型为其生成一个(或一组)向量表示。

查询阶段。

粗召回。首先根据用户查询,召回最相关的Top-k个大块。

动态细切。接着,在这些被召回的大块内部,实时地、动态地进行更细粒度的切分。切分策略可以很多样,例如,可以围绕与查询最相似的句子进行扩展,形成一个上下文窗口。

精排与生成。最后,对这些动态生成的小块进行重排序,将最相关、质量最高的小块送入LLM生成答案。

4.2 后分块的核心优势

最大化上下文保留。Embedding是在看到全局信息的情况下生成的,因此向量的质量更高,更能捕捉长距离的依赖关系。这从根本上解决了预分块的上下文割裂问题。

精准定位证据。它实现了“用大块的上下文进行检索,用小块的精准信息进行生成”的理想模式。粗召回保证了相关信息不会丢失,动态细切则确保了送入LLM的是信噪比极高的“手术刀式”的精准证据。

提升复杂问题处理能力。对于那些答案散落在多个段落,需要整合才能回答的复杂问题,后分块的能力远超预分块。因为它可以在召回的大块内部自由地组合和提取证据。

4.3 前提与代价

后分块并非没有代价,它的实现依赖于一系列技术前提,并带来了新的工程挑战。

模型依赖。需要能够处理长文本并输出高质量向量表示的Embedding模型。一些晚期交互(Late-Interaction)模型,如ColBERT,其思想与后分块不谋而合,它们为每个Token生成上下文感知的向量,非常适合这种范式。

查询成本与延迟。查询时的计算量显著增加。动态切分和对多个小块的重排,都使得查询延迟(P95 Latency)变得更高、更不可控。

系统复杂度。整个检索链路变得更长、更复杂。缓存策略、索引管理和在线计算资源的调度都面临更大的挑战。

4.4 适用场景

后分块是追求性能上限的利器,但并不适用于所有场景。

超长文档处理。如处理一份数百页的财报或法律文件,用户的问题往往只与其中一两个段落相关。后分块能精准地从长文中“抠出”所需证据。

高精度问答系统。在金融、医疗、法律等对答案准确性要求极高的领域,后分块带来的精度提升是值得付出额外成本的。

可容忍更高延迟的场景。对于一些内部知识库或专家分析系统,用户对毫秒级的响应时间不那么敏感,更看重答案的质量。

🎯 五、选型框架:何时优先预分块?

%20拷贝-wime.jpg)

尽管后分块代表了性能的前沿方向,但在当前的工程实践中,高质量的预分块仍然是绝大多数生产环境的基石。清晰地界定两者的适用边界至关重要。

优先选择预分块(Pre-Chunking)的场景:

大规模、高并发的生产环境。

当系统需要服务海量用户,对查询的平均延迟和尾部延迟(P99 Latency)有严格的服务等级协议(SLA)要求时,预分块的优势在于其查询链路简单、稳定、可预测。所有复杂的计算都在离线阶段完成,在线服务的开销极低。知识库更新频繁的场景。

如果知识库需要频繁地进行增量更新,预分块的模式更加高效。每次只需对新增或修改的文档进行分块和索引即可。而后分块模式下,如果大块的定义与文档边界不一致,更新可能会更复杂。文档结构清晰且规范。

当你的知识库由大量结构良好的文档(如API文档、格式化的报告)组成时,基于结构的预分块策略往往已经能达到非常好的效果,引入后分块带来的边际效益可能并不显著。成本敏感型应用。

预分块的计算和存储成本相对固定和可控。后分块带来的在线计算开销和对更强大Embedding模型的需求,会直接转化为更高的运营成本。对于预算有限的项目,预分块是更务实的选择。

决策流程建议:

可以采用一个渐进式的决策框架。

基线建立。从最稳健的递归分块或结构化分块开始,建立一个性能基线。

性能评测。通过下面将要讨论的评测体系,量化分析基线方案在关键指标上的表现,识别出主要的性能瓶颈(是召回率不足,还是上下文噪声太大?)。

瓶颈驱动优化。

如果问题在于语义割裂,可以尝试引入语义分块。

如果问题在于召回了错误的逻辑单元,检查结构化解析是否准确。

如果上述预分块策略优化后,对于长文档的复杂问题仍然表现不佳,且业务愿意为更高的精度付出成本,此时再考虑引入后分块作为“攻坚武器”。

🎯 六、科学评测与迭代

选择分块策略不能凭感觉,必须建立一套科学的、可量化的评测体系。评测应覆盖从检索到生成的全链路。

6.1 关键评测指标

检索层指标。

召回率@k (Recall@k)。评估在前k个召回结果中,包含了正确答案的比例。这是衡量检索系统“查全”能力的核心指标。

归一化折扣累计增益 (nDCG@k)。不仅考虑是否召回,还考虑相关结果的排序位置,是衡量排序质量的金标准。

上下文命中率 (Context Hit Rate)。一个更直接的指标,衡量召回的上下文片段是否真正包含了生成答案所需的全部证据。

生成层指标。

答案F1/精确匹配 (Answer F1/Exact Match)。对于有标准答案的问答对,直接比较生成答案与标准答案的重合度。

幻觉率 (Hallucination Rate)。通过人工评估或使用更强的LLM作为裁判,评估生成答案中包含多少与原文不符或无法从原文推断出的信息。

答案相关性 (Answer Relevance)。评估生成的答案是否切中用户问题的要点。

系统层指标。

端到端延迟 (End-to-End Latency)。从收到用户查询到返回最终答案的总耗时。

成本 (Cost)。包括API调用费用、计算资源消耗等。

6.2 实验设计

进行分块策略对比实验时,应遵循单变量原则。

固定其他组件。保持Embedding模型、向量数据库、重排器和生成LLM不变。

变量控制。仅改变分块策略(如方法、块长、重叠)。

双轨评估。

离线评估。构建一个高质量的评测数据集(包含查询、相关文档、标准答案),在离线环境下运行不同策略,计算上述量化指标。

在线A/B测试。将最有潜力的几种策略部署到线上,通过A/B测试,观察它们在真实用户流量下的表现,收集业务指标(如用户满意度、点击率等)。

🎯 七、常见陷阱与修复策略

%20拷贝-ubon.jpg)

在工程实践中,处理真实世界的文档,总会遇到各种“脏数据”带来的挑战。

陷阱1:PDF页眉页脚噪声。

PDF解析时,常常会将每页的页眉、页脚、页码等无关信息混入正文,污染分块内容。修复。使用更智能的PDF解析工具(如Nougat、Marker),或编写规则来识别和剔除这些重复性的噪声元素。

陷阱2:表格与代码块被打断。

固定长度或简单的段落分块,很容易将一个完整的表格或代码块拦腰截断,使其失去价值。修复。在文档预处理阶段,显式地识别表格和代码块,将它们作为一个不可分割的原子单元进行处理,即使它们的长度超过了常规阈值。

陷阱3:跨页引用与上下文失联。

文档中常见的“参见第X章”或脚注,在分块后可能与其引用的内容分离,导致上下文丢失。修复。这需要更高级的上下文关联策略。一种方法是在分块时,为每个块添加元数据(Metadata),如其所属的章节、标题。另一种更复杂的方法是,在检索到一个包含引用的块时,自动地将它引用的目标块也一并召回。

陷阱4:过大块导致重排失效。

当一个块非常大时,即使它包含了正确答案,也可能因为整体噪声太多,导致在重排阶段被一个更短但主题更集中的无关块超越,从而被错误地排在后面。修复。这是后分块试图解决的核心问题之一。对于预分块,可以通过设置一个合理的块长上限,或采用分层检索的架构来缓解。

🎯 八、架构模式与领域适配

单一的分块策略往往不够,先进的RAG系统通常会采用组合式的架构模式,并针对特定领域进行适配。

8.1 架构模式

两阶段检索 (Two-Stage Retrieval)。

这是最经典的优化模式。第一阶段使用高效的向量检索(如FAISS, HNSW)从海量数据中快速召回一个较大的候选集(如Top 100)。第二阶段使用更强大但计算更昂贵的交叉编码器(Cross-Encoder)或重排LLM,对这个小候选集进行精细化重排。分块策略需要同时考虑这两个阶段的需求。混合检索 (Hybrid Search)。

将基于向量的稠密检索(Dense Retrieval)与基于关键词的稀疏检索(Sparse Retrieval,如BM25, SPLADE)相结合。这种模式能同时利用语义相似性和关键词匹配的优点,鲁棒性更强。分块时需要考虑两种检索器的特性。层级检索 (Hierarchical Retrieval)。

与分层分块相对应。先在粗粒度(如章节)上进行召回,锁定相关的大范围上下文,然后再在这个范围内进行细粒度(如句子)的精确定位。

8.2 领域适配

分块策略需要根据知识库的领域特性进行定制。

代码/API文档。应以函数(Function)或类(Class)作为基本的分块单元,并尽可能保留其完整的签名、注释和示例代码。保持调用链的上下文完整性至关重要。

法律/标准文档。应以条款(Clause)为单位,并严格保留其编号(如“第3.1.2条”),因为这些编号本身就是重要的上下文信息和引用关系。

日志/工单数据。可以结合时间窗口和事件语义进行分块。将时间上相邻且语义上相关的事件(如一个故障的发生、诊断、解决过程)聚合到一个块中。

结论

分块,作为RAG系统的“数据地基”,其重要性不言而喻。我们从一个看似简单的文本切割问题出发,遍历了从固定长度到后分块的完整方法谱系。可以看到,不存在一劳永逸的“银弹”。每种策略都是在效果、成本、延迟这个“不可能三角”中的一次取舍。

“先Embedding后分块”的后分块范式,无疑为追求极致性能的场景打开了一扇新的大门。它通过将分块操作后置,最大化地保留了全局上下文,是解决长文档信息抽取难题的有力武器。然而,我们必须清醒地认识到其背后高昂的工程与算力代价。

对于广大的工程实践者而言,最稳健的路径是:以高质量的预分块(特别是递归分块和结构化分块)作为坚实的基线,建立起科学的评测体系,然后根据业务瓶颈,审慎地、渐进地引入更复杂的语义分块、分层检索乃至后分块策略,形成一个适合自身业务场景的混合解决方案。这,或许才是RAG分块在当前阶段最真实的“王道”。

📢💻 【省心锐评】

分块没有银弹。预分块是生产基石,后分块是性能尖兵。从稳健的递归分块起步,用数据驱动决策,结合业务场景选择最合适的“积木”搭建你的RAG系统,才是工程的智慧。

.png)

%20%E6%8B%B7%E8%B4%9D-naos.jpg)

评论